はじめに

GLB事業部Lakehouse部の阿部です。

Databricks社が主催するDATA + AI SUMMIT(DAIS)が今年も開催されます!

Databricksは去年の秋ごろに、レイクハウスプラットフォームというシステムからData Intelligence Platformという新世代のシステムを発表しました。

今年のDAISのセッションもそのキーワードで検索すると11セッションもあり、この言葉を広めて行こうという思惑も伺えます。

https://www.databricks.com/dataaisummit/agenda?page=1&query=Data+Intelligence+Platform

本記事では、Data Intelligence Platformが生まれるまでの歴史を解説した後、関連セッションを紹介して終わりたいと思います。

- はじめに

- データ分析プラットフォームを取り巻く技術進化の歴史

- データレイクハウスの課題、そしてDatabricksのData Intelligence Platform

- 気になるセッション

- おわりに

- DAIS期間中の特設サイトについて

データ分析プラットフォームを取り巻く技術進化の歴史

学問や何かを学ぶには歴史からという言葉もある(?)通り、Data Intelligence Platformという言葉が生まれるまでの歴史を学び、どのような進化を遂げたか理解することがまずは重要だと思いました。

実際、これから紹介するプラットフォームや技術を活用できている企業は多くないと思うため、データ活用を考える企業が現状どの段階にいるか理解する参考になれば幸いです。

1960年代:初期のデータ分析

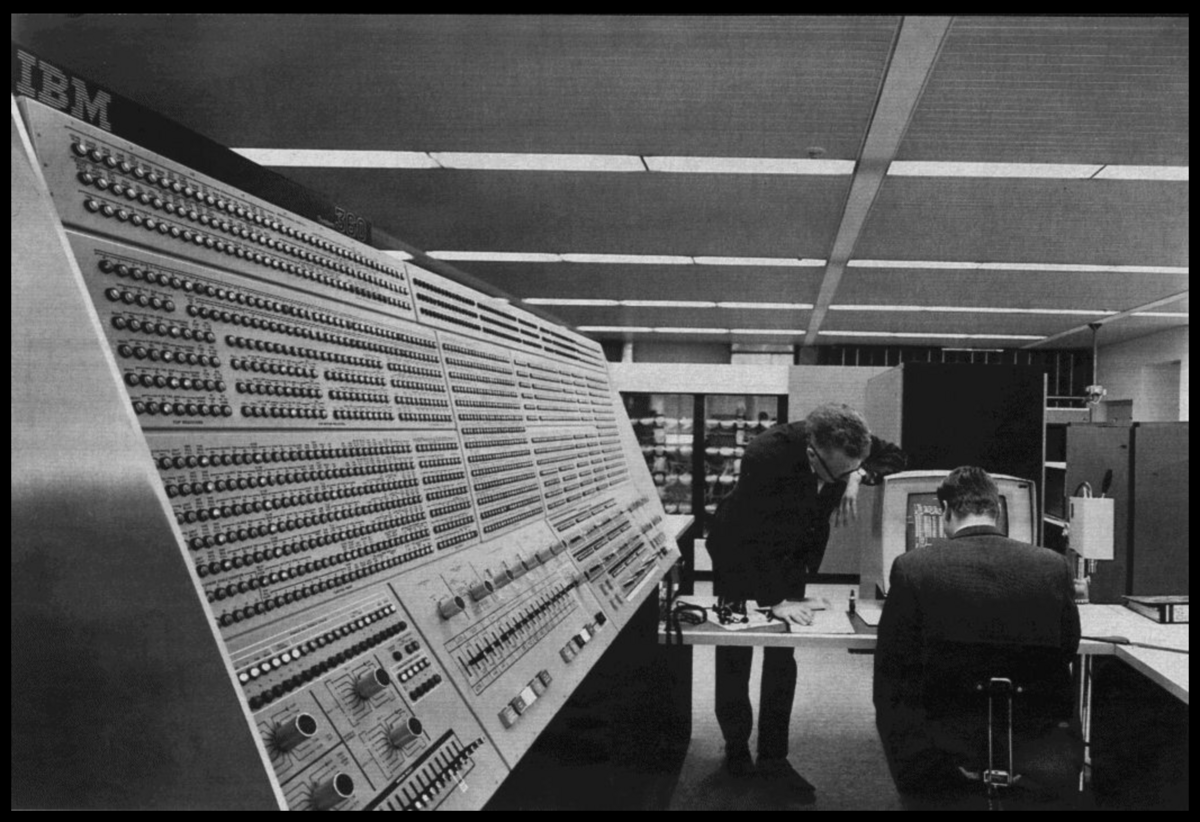

大規模なデータ処理能力を持つメインフレームコンピューターが登場し、コンピューター技術が商業および科学的なデータ処理に導入された時代です。

さまざまな産業でデータ分析が進められ、統計解析や回帰分析、数値シミュレーションやモデリングに利用されました。

このメインフレームは、あの有名なアポロ計画を含むNASAの宇宙探査活動にも使われていたようで、下は1960年代にNASAに設置されたメインフレームコンピューターです。

引用元

https://ja.wikipedia.org/wiki/%E3%83%A1%E3%82%A4%E3%83%B3%E3%83%95%E3%83%AC%E3%83%BC%E3%83%A0

1970年代:リレーショナルデータベースの登場

リレーショナルデータベース(RDBMS)は、1970年にIBMの研究者エドガー・F・コッド(Edgar F. Codd)によって提唱されました。

コッドの論文「A Relational Model of Data for Large Shared Data Banks」は、データベース管理の新しいアプローチを紹介し、その後のデータベース技術の発展に大きな影響を与えました。

現在では当たり前ですが、テーブル(リレーション)、キー、正規化、SQLといった概念はコッドが提唱したものです。

その後、OracleやIBM DB2などの商業用リレーショナルデータベースシステムが登場し、データの管理と操作が飛躍的に改善され、ビジネスや科学研究におけるデータ活用が大きく進展しました。

1980年代:データウェアハウス(DWH)の確立

データウェアハウスの基本的な概念と技術が確立され、企業の意思決定支援システムとしての役割が明確になった時期です。

ビジネス環境がより複雑化し、企業は意思決定を迅速かつ正確に行う必要性が高まっていく中で、以下のブレイクスルーを通してデータウェアハウスの概念が発展しました。

ハードウェアの進化

- メインフレームからミニコンピューター、そしてパーソナルコンピューター(PC)へとハードウェア技術が進化し、データ処理能力が向上

- 大容量ストレージのコストが下がり、データの保存がより現実的に

ソフトウェアとデータベース技術の進化:

- RDBMS(リレーショナルデータベース管理システム)の普及により、データの管理とクエリが容易になりました。

- IBMのDB2やOracleが登場し、データベース技術の基盤を形成しました。

ETLプロセスの誕生:

- ETL(Extract, Transform, Load)プロセスが導入され、データの抽出、変換、ロードの自動化が進展

- データの整合性とクオリティが向上し、分析の信頼性が向上

以上の技術進歩を通して、ETLプロセスにより加工されたビジネスデータをDWHに集約し、効率よく分析できる分析プラットフォームが誕生しました。

1990年代:ビジネスインテリジェンス(BI)

BIとは、企業がデータを収集・分析し、意思決定を支援するための技術とプロセスのことです。

1980年代に誕生し、1990年代に確立したDWH上で分析用のデータに変換し、そのデータをBI上で可視化できるようになりました。

BIの例としてレポーティングツールが登場し、ユーザーはグラフなどの視覚的なデータを参照できるようになり、とくに技術的な知識がないユーザー向けに、ドラッグ&ドロップなどの簡単操作でレポート作成が可能になりました。

さらに、OLAP(Online Analytical Processing)の登場は、BIの進化に大きく寄与しました。

多次元データモデルやキューブ(データキューブ)といった概念も生まれ、複雑なクエリを迅速に実行し、多次元的なデータ分析が可能になりました。

2000年代:ビッグデータと分散コンピューティング

ビッグデータと分散コンピューティングの技術が急速に発展し、データ処理と分析の方法が大きく変革した時期です。

インターネットの普及、SNS、IoTの登場により膨大なデータが日々生成され、リアルタイムデータ処理やストリーミングデータの需要が増加しました。

さらにテキストや画像、動画、センサーデータなど、データ形式も多様化したことで、データの信頼性と品質の確保が重要になった時期です。

以上のビジネス要件に対して、分散コンピューティングが進化し、Apache Hadoop、MapReduce、NoSQLデータベース(MongoDB、Cassandraなど)が登場し、分散コンピューティングによるビッグデータの処理が可能になりました。

2010年代-1:クラウドコンピューティングとリアルタイム分析

クラウドコンピューティングとは、インターネット経由でコンピューティングリソース(サーバー、ストレージ、データベース、ネットワーキング、ソフトウェアなど)を提供するサービスであり、ビジネスや個人のITインフラに革命をもたらしました。

企業は柔軟でコスト効率の高いインフラを利用できるようになり、リアルタイム分析の技術の進化もあり迅速な意思決定とアクションが可能になりました。

これにより、さまざまな産業でのデータ活用が一層進化し、その競争力が向上しました。

2010年代-2: データレイクの誕生とデータレイクハウスへの進化

データレイクとは、さまざまな形式のデータを生データとして大量保存する中央リポジトリです。

初期のデータレイクは、主にオンプレミスのHadoopクラスター上で構築され、Apache Hive(データウェアハウス)、Apache Pig(データフロー言語)、Apache HBase(NoSQLデータベース)など、Hadoopを中心としたエコシステムが構築されました。

クラウドコンピューティングの普及もあり、クラウドベースのデータレイクが登場して柔軟性とスケーラビリティが大幅に向上しました。

しかし、データレイクにはACIDトランザクションのサポートがなく、メタデータの管理ができないこともあり、データ品質の保証ができないという欠点がありました。

そこで、Databricksがデータレイクハウスを提唱し、データレイクとデータウェアハウスの機能を統合したデータ管理システムが使われるようになり、さまざまなデータ形式を対象にデータ分析が可能になります。

データレイクハウスは、データ収集や加工・溜め込みが可能になり、機械学習やBIツールとの連携といったワークロードが1つのプラットフォームで可能になりました。

もちろん、これらのビッグデータ処理が可能なのは、Apache Sparkの分散処理技術が根底にあります。

1つのプラットフォームにあるデータなどの資産を複数のユーザーで共有するため、アクセス管理といったデータガバナンスの強化に伴い、データライフサイクル管理が行われました。

データレイクハウスの課題、そしてDatabricksのData Intelligence Platform

しかし、これまでのレイクハウスでは以下の課題があるとDatabricksは述べています。

技術スキルの壁:データクエリにはSQL、Python、BIの専門スキルが必要なため、学習曲線が険しくなる。

データの正確性とキュレーション:大規模な組織では、適切で正確なデータを見つけることは困難であり、大規模なキュレーションと計画が必要となる。

管理の複雑さ:データ・プラットフォームは、高度な技術者によって管理されなければ、コストが高騰し、パフォーマンスが低下する可能性がある。

ガバナンスとプライバシー:世界中のガバナンス要件は急速に進化しており、AIの出現により、血統、セキュリティ、プライバシーに関する懸念が増幅している。

新たなAIアプリケーション:ドメイン固有の要求に答える生成的なAIアプリケーションを可能にするために、組織はデータとは別のプラットフォームでLLMを開発・調整し、手作業によるエンジニアリングでデータに接続しなければならない。

引用元 https://www.databricks.com/jp/blog/what-is-a-data-intelligence-platform

つまり、プラットフォームが進化して求められる技術スキルが高くなったことや、データの増大やAIの登場によりデータガバナンスの要件が一層求められ、レイクハウスではLLM開発機能が統合されていないことが課題だと理解しています。

これらの課題に対して、(Generative)AIを活用してデータの民主化をさらに実現させる考え方が提唱されています。

詳しい内容は割愛しますが、これまで以上にユーザーがデータにアクセスしやすくなり、ユーザーがデータの意味を理解できるようになること、データ管理者としてはデータガバナンスを強化でき、そしてプラットフォームとしてGenerative AIの開発機能・他サービスとの連携が向上され、進化しました。

気になるセッション

以上でData Intelligence Platformが生まれるまでの歴史の振り返りは終わりますが、DatabricksのData Intelligence Platformを理解するにはDAISのキーノートやセッションを見ることが一番かと思います。

そのため、DAISで発表予定のData Intelligence Platformに関するセッションを紹介して記事を終わりたいと思います。

- DATABRICKS DATA INTELLIGENCE PLATFORM: INTRODUCTORY OVERVIEW

こちらのセッションは、DatabricksのData Intelligence Platformを体系的に理解できるセッションかと思います。

とくにGenerative AIの機能を搭載したDatabricksアシスタント、AIセマンティック検索、AIドキュメンテーション、クエリエディターのアシスタント、Predictive I/O、LLM/RAG/ファインチューニングなどのAIアプリケーションの構築などについて説明されるようです。

- YOUR GUIDE TO DATA ENGINEERING ON THE DATA INTELLIGENCE PLATFORM

こちらのセッションは、データエンジニアリング業務に関わる方が、Databricksの機能をどのように使って課題を解決するかのガイドかと思います。

セッションのアジェンダは、以下のようになっています(日本語訳)

- Data Intelligence Platformへのデータ取り込み

- Delta Live Tablesを使用した信頼性の高いストリーミングデータパイプラインの構築

- Databricksワークフローによるデータオーケストレーション

- Unity Catalogによるデータガバナンス

- Databricks Assistantなどの便利なAI機能

おわりに

Data Intelligence Platformが生まれるまでの歴史を技術進歩とともに振り返りました。

初期のメインフレームによるデータ分析からデータレイクハウスプラットフォームは進化し、現在はData Intelligence Platformが誕生しました。

今後のGenerative AIを活用したプラットフォームの進化が楽しみです。

DAIS期間中の特設サイトについて

今年もDAIS現地からセッション内容や様子をレポートする特設サイトをご用意しました! DAIS期間中は毎日ブログを更新していく予定ですので、ご覧いただければと思います。