はじめに

こんばんは、ACS事業部の吉川です。

引き続き Microsoft Build で発表された内容からピックアップしてお届けします。

やはり今回はAI系が中心ということで、本記事では Azure AI Content Safety についてお届けします。

AIによるモデレート

Azure AI Content Safety はテキスト、あるいは画像に不適切な内容が含まれないかをチェックするためのサービスです。

Buildのセッションの中では、Chat Botに対するユーザーの問い合わせ内容が不適切でないか、という利用シーンを例示していました。

試してみる

Azure AI Content Safety は既にプレビューとして利用可能となっています。

リソースを作成後、簡単にブラウザから操作できる Azure AI Content Safety Studio が利用できるため、こちらで動作を試してみましょう。

テキストコンテンツのモデレート

Azure AI Content Safety Studio ではサンプルの文字列が用意されています。

問題のない、安全なテキストの例は以下のとおりでした。

Chopping tomatoes and cut them into cubes or wedges are great ways to practice your knife skills.

「トマトを切るのはナイフの練習にいいですよ」というような内容ですね。 こちらを判定してみましょう。

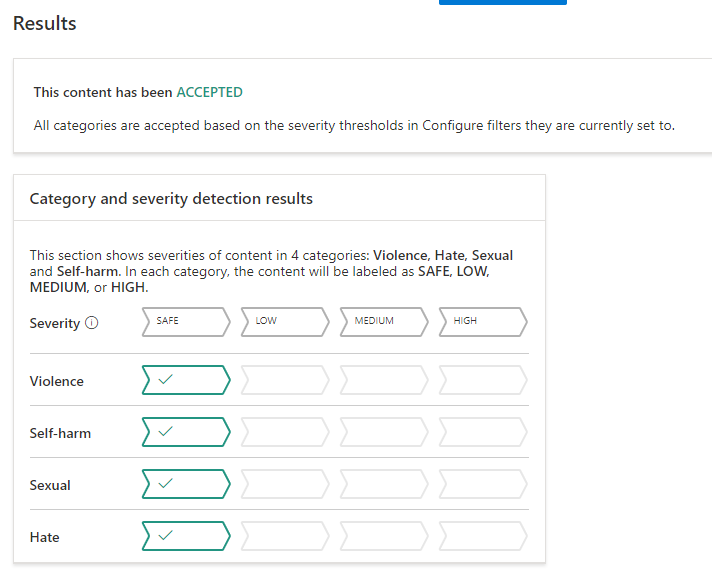

以下の4つの軸で評価されます、

- Violence(暴力)

- Self-harm(自傷)

- Sexual (性的)

- Hate (嫌悪)

画像の通り、結果はどの評価軸においても問題なしとして、ACCEPTED と判定されました。

では次に問題のある文章を入力してみましょう。

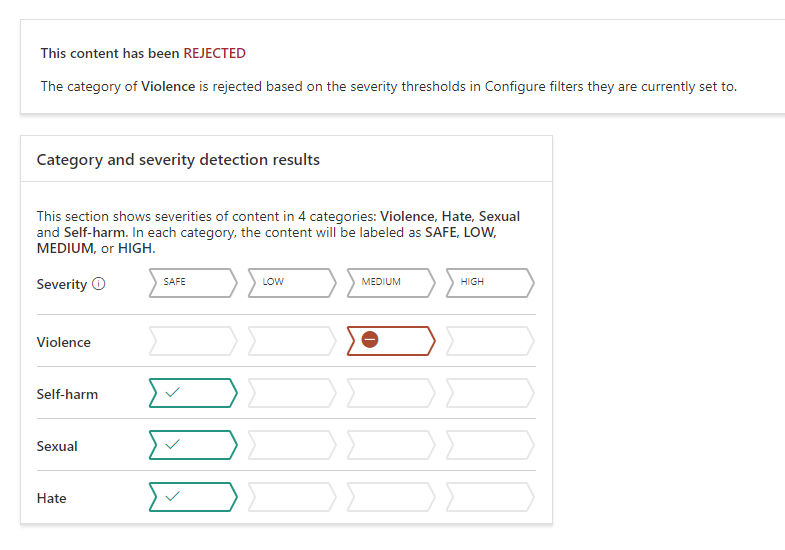

サンプルに Violent content with misspelling というものが用意されているのでこちらを入力してみます。どんな文章なのかはここには貼りません。判定結果のみをお見せします。

Violenceのスコアが下がり、REJECTED と判定されました。

このように評価内容によってAccept/Rejectが判定されます。

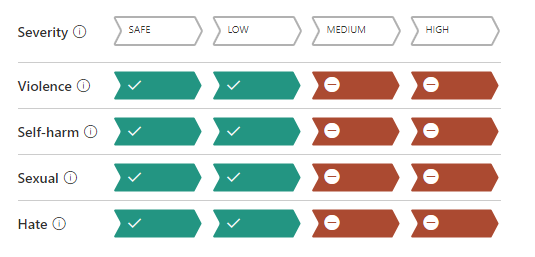

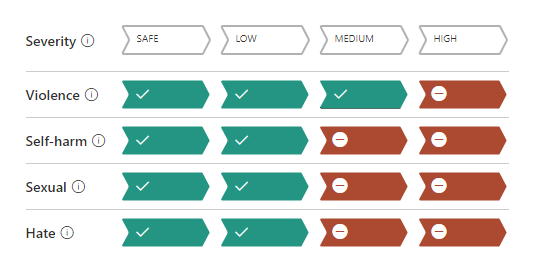

なお、評価軸ごとの閾値を変更することもできます。以下がデフォルトの設定です。

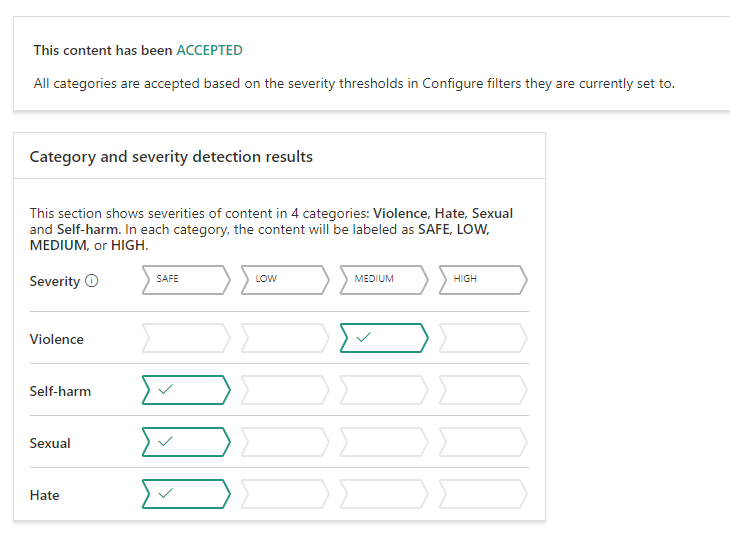

これをViolenceをMEDIUMまで許可するように閾値を変更し、

再度判定を行うと、今度は ACCEPTED と判定されました。

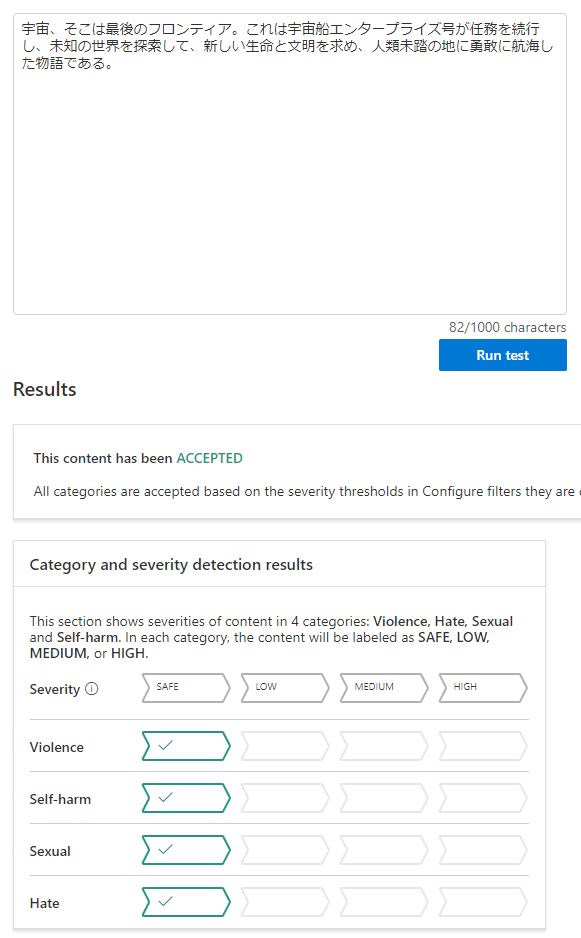

ちなみに日本語にも対応しています。

画像コンテンツのモデレート

テキストの次は画像で試してみましょう。

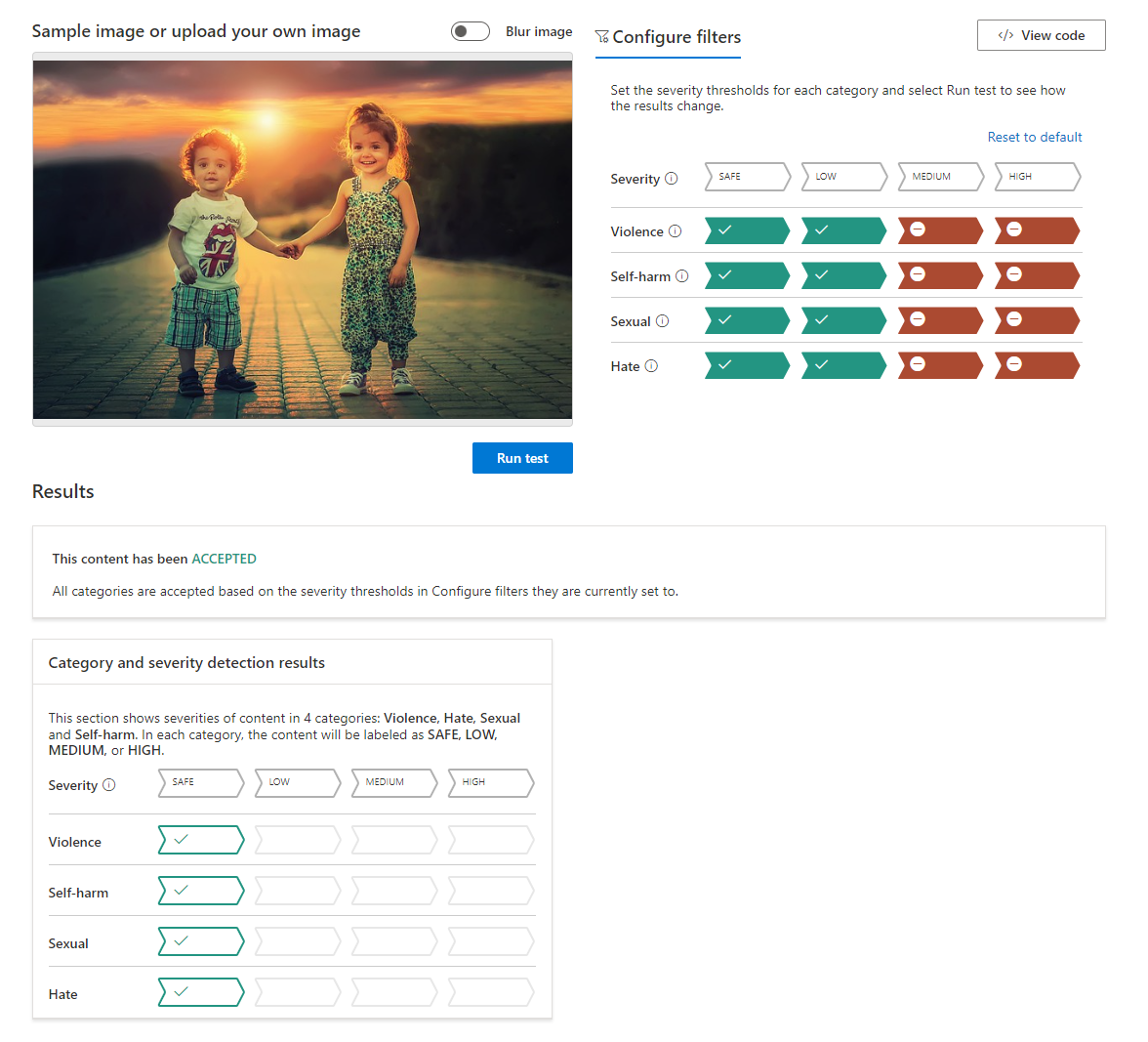

同じくサンプル画像が用意されていますのでこちらで判定してみます。まずは安全なコンテンツから。

見てのとおり問題のない画像なので、 ACCEPTED と判定されていますね。

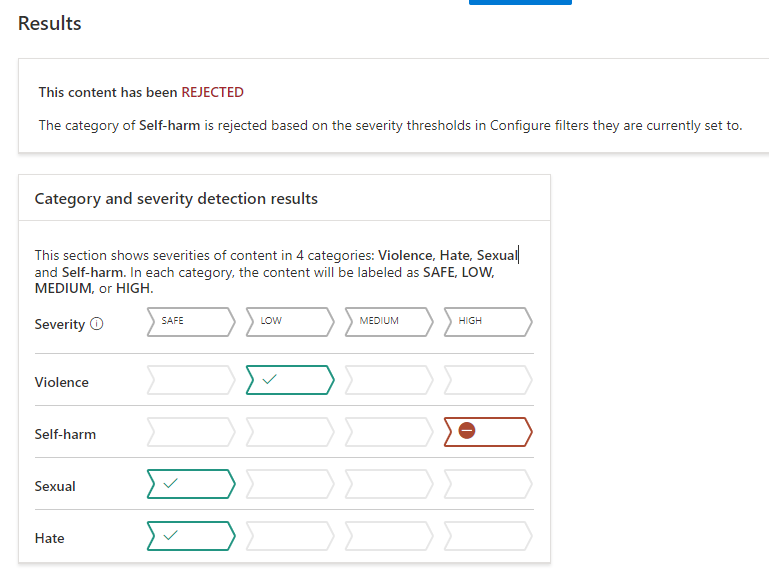

では、問題のあるサンプルで再度判定します。Self-harm contentというサンプルを利用しました。

結果のみをお見せしていますが、正しく REJECTED 判定されています。

このように、テキストと同様に画像についても判定可能なサービスです。

アプリケーションに組み込む

上記はAzure AI Content Safety Studioの操作で説明しましたが、実際のアプリケーションに組み込んで使うには向いていないでしょう。

アプリケーションと連携を容易にするためにREST APIが準備されています。

westus.dev.cognitive.microsoft.com

PythonのSDKも公開されています。

アプリケーションに組み込む場合にはこれらを利用するとよいでしょう。

その他、公式ドキュメントにいろいろと情報があるので、実際に利用する際はよく見ておきましょう。

利用シーン

ではどんな時に Azure AI Content Safety を利用すればよいでしょうか。 パッと思いつくところでは、ユーザーが自由に情報を投稿できるレビュー機能を持ったECサイトや、チャット機能を持ったゲームなどに利用可能かと思います。また、LLMモデルが出力した文字列に問題がないかチェックする、という使い方も有用でしょう。ユーザーの目に触れる前に問題のあるコンテンツをブロックしたいというシーンで有用に使えそうなサービスです。

おわりに

Buildの中では様々なAIサービスの紹介がありましたので、今後もチェックしていきたいと思います。

【PR】

私達ACS事業部はAzure・AKSなどのクラウドネイティブ技術を活用した内製化のご支援をしております。

また、一緒に働いていただける仲間も募集中です!

今年もまだまだ組織規模拡大中なので、ご興味持っていただけましたらぜひお声がけください。