はじめに

こんにちは。エーピーコミュニケーションズ クラウド事業部の髙野です。

今回は、以下の記事で紹介している Microsoft Entra ID 上のユーザーを AWS 環境に同期する手順の Google Workspace 版ということで、 Google Workspace ユーザーを IAM Identity Center ユーザーとしてAWS 環境に同期するための手順を紹介します。

なお、今回は少しボリュームがあるので本記事を含め3つの記事に分けて投稿します。

IAM Identity Center に関しては以下の記事を参照してください。

本記事で紹介している手順は以下を参考に記載しております。

前提条件

- AWS アカウントで IAM Identity Center が有効になっていること。

- Google Workspace 特権管理者権限を持つアカウントにサインインできること。

- すべての Google Workspace ユーザーにおいて、[名]、[姓]、[ユーザー名]、[表示名] の値が指定されていること。

- 各 Google Workspace ユーザーには、E メールアドレスや電話番号などのデータ属性ごとに 1 つの値のみが割り当てられていること。

目次

- AWS のカスタムユーザー属性を作成する★

- ID プロバイダーのメタデータをダウンロードする★

- Google Workspace で Amazon Web Services アプリをセットアップする★

- IAM Identity Center の ID ソースを変更し、Google Workspace を SAML ID プロバイダーとして設定する★

- Google Workspace でアプリを有効にする

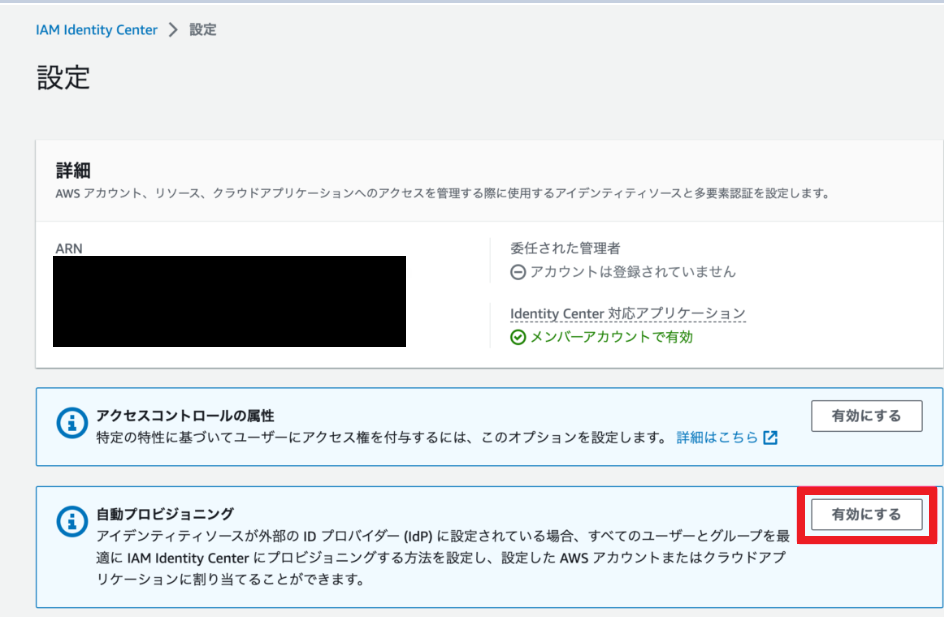

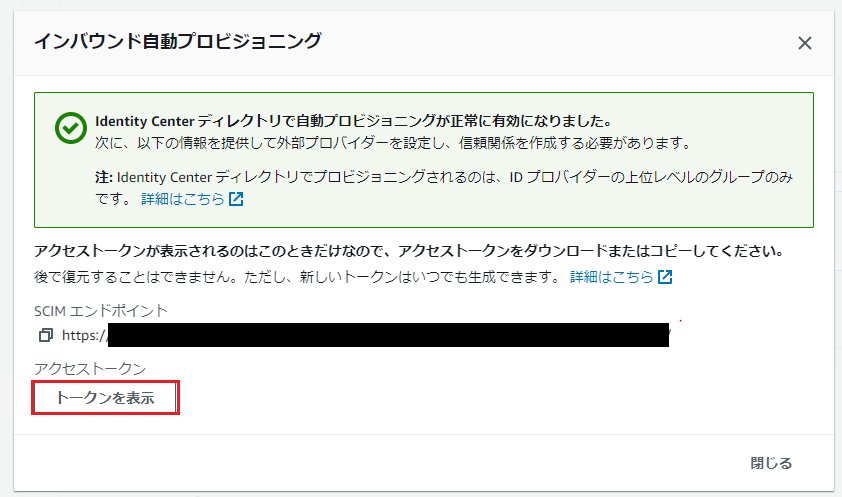

- IAM Identity Center の自動プロビジョニングを設定する

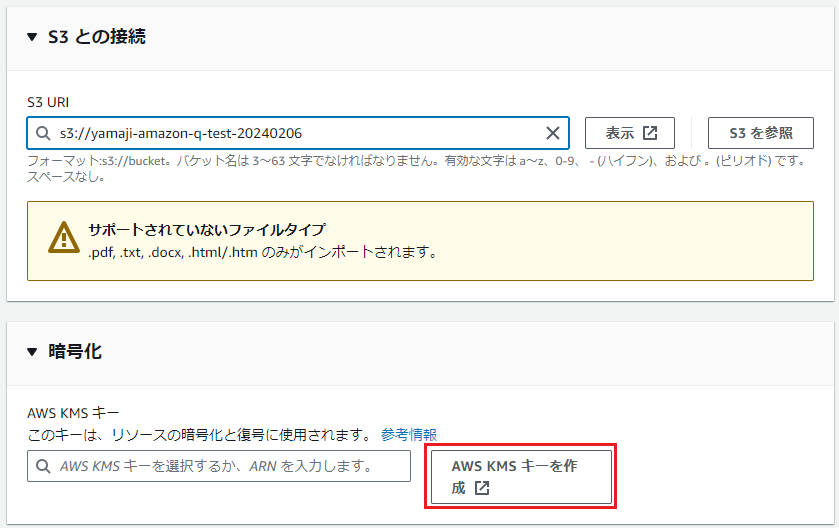

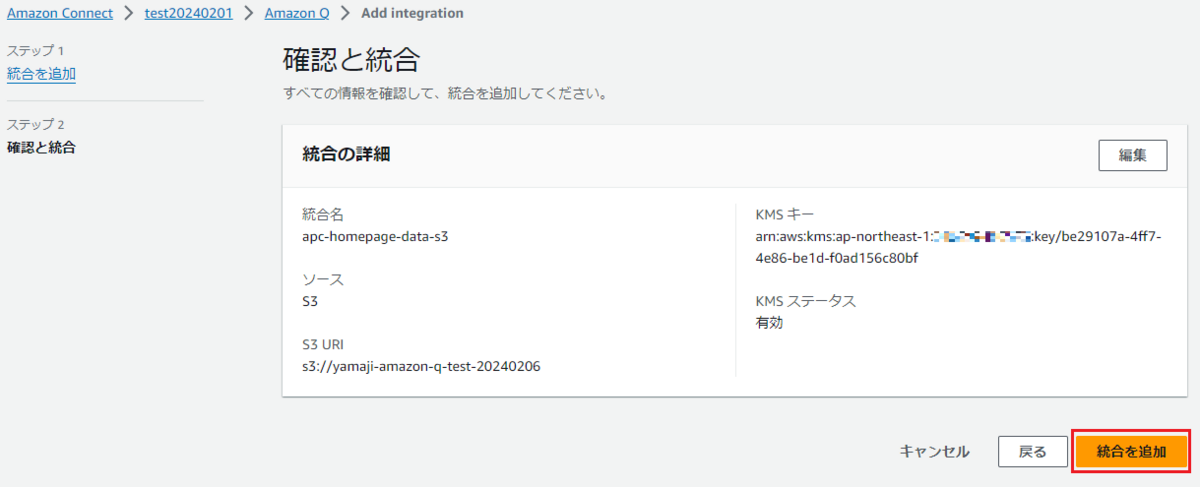

- Google Workspace で自動プロビジョニングを設定する

- IAM Identity Center グループを作成する

- Google Workspace ユーザーをIAM Identity Center グループに追加する

- IAM Identity Center グループにアカウントへのアクセス権を付与する

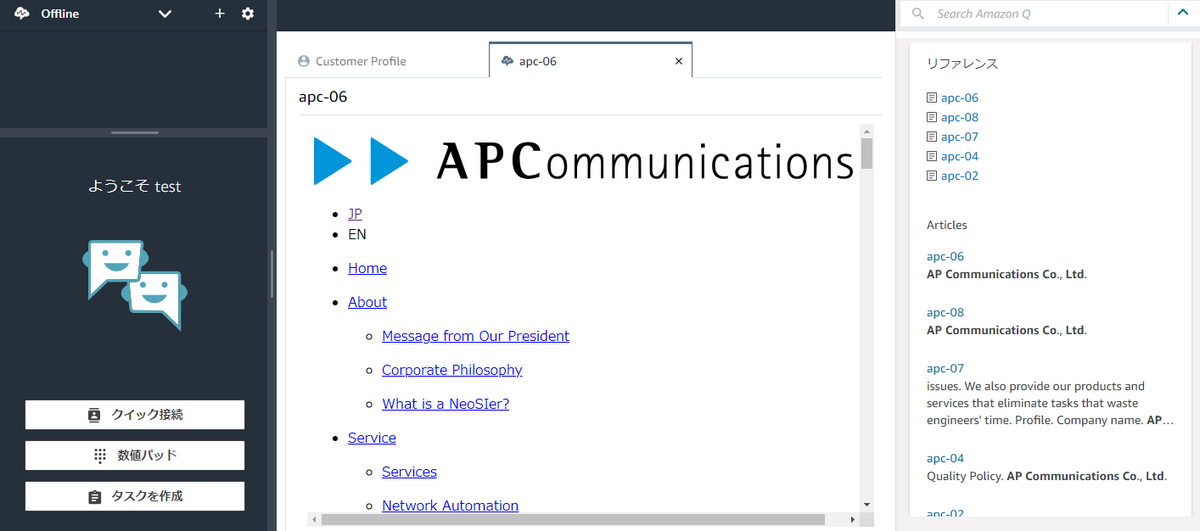

- Google Workspace ユーザーの AWS リソースへのアクセスを確認する

手順

1.AWS のカスタムユーザー属性を作成する

1-1.特権管理者権限を持つアカウントを使用して [Google管理コンソール] にサインインします。

1-2.左側のナビゲーションパネルで、[ディレクトリ]、[ユーザー] の順に選択します。

1-3.[ユーザー] リストの上部にある [その他のオプション] を選択し、[カスタム属性を管理します] を選択します。

1-4.ページの右上にある [カスタム属性を追加] を選択します。

1-5.[カスタムフィールドを追加] ウィンドウで、以下のフィールドに入力します。

- [カテゴリ] : Amazon

- [説明] : Amazon Custom Attributes

- [カスタムフィールド] : Role、テキスト、ユーザーと管理者に表示、複数の値

[保存] を選択します。

2.ID プロバイダーのメタデータをダウンロードする

2-1.[Google管理コンソール] の左側のナビゲーションパネルで、[セキュリティ] を展開し、[認証]、[SAML アプリケーションによる SSO] を選択します。

※コンソールのレイアウトによっては、[さらに表示] を選択してナビゲーションパネルの [セキュリティ] セクションを表示する必要がある場合があります。

2-2.[IdP メタデータ] で [メタデータをダウンロード] を選択します。

[GoogleIDPMetadata.xml] ファイルはデフォルトのダウンロードフォルダに保存されます。

[Google管理コンソール] は、このあとの手順でも操作を行うため、開いたままにしておいてください。

3.Google Workspace で Amazon Web Services アプリをセットアップする

3-1.Google管理コンソールの左側のナビゲーション パネルで、[アプリ]を展開し、[ウェブアプリとモバイルアプリ]を選択します。

3-2.[アプリを追加]を選択し、 [アプリを検索]を選択します。

3-3.検索ボックスに「 Amazon Web Services 」と入力し、 リストからAmazon Web Servicesを選択します。

3-4.[続行]を選択します。

※Google ID プロバイダの詳細ページには、メタデータをダウンロードするか、SSO URL、エンティティ ID、および証明書をコピーするオプションがあります。手順 2 で IdP メタデータをダウンロードしたため、これらの項目のいずれも実行する必要はありません。

3-5.[サービス プロバイダの詳細]ページで、AWS のACS URLとエンティティ ID の値がデフォルトで設定されていることを確認し、[続行]を選択します。

3-6.[属性のマッピング]ページの [属性]で、次のフィールドをGoogle ディレクトリ属性の下に追加します。

[Basic Information]、[Primary Email]フィールドを選択し、アプリの属性として次のように入力します。 https://aws.amazon.com/SAML/Attributes/RoleSessionName

「Amazon」、「Role」フィールドを選択し、アプリの属性として次のように入力します。 https://aws.amazon.com/SAML/Attributes/Role

※Amazon、Role は、手順 1で作成したカスタム属性です。

3-7.完了を選択してください

4.IAM Identity Center の ID ソースを変更し、Google Workspace を SAML ID プロバイダーとして設定する

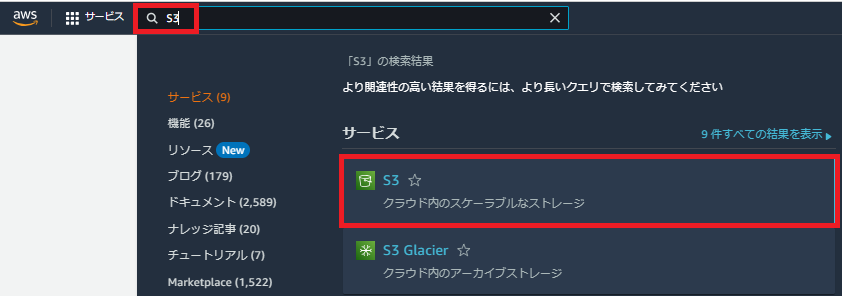

4-1.管理者権限を持つロール又はユーザーで IAM Identity Center コンソールにサインインします。

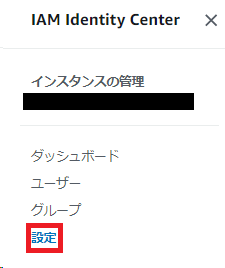

4-2.左側のナビゲーションペインで[設定]を選択します。

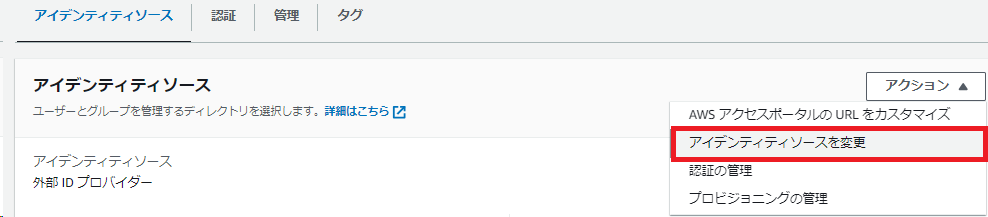

4-3.[設定]ページで、[アクション]を選択し、[アイデンティティソースを変更]を選択します。

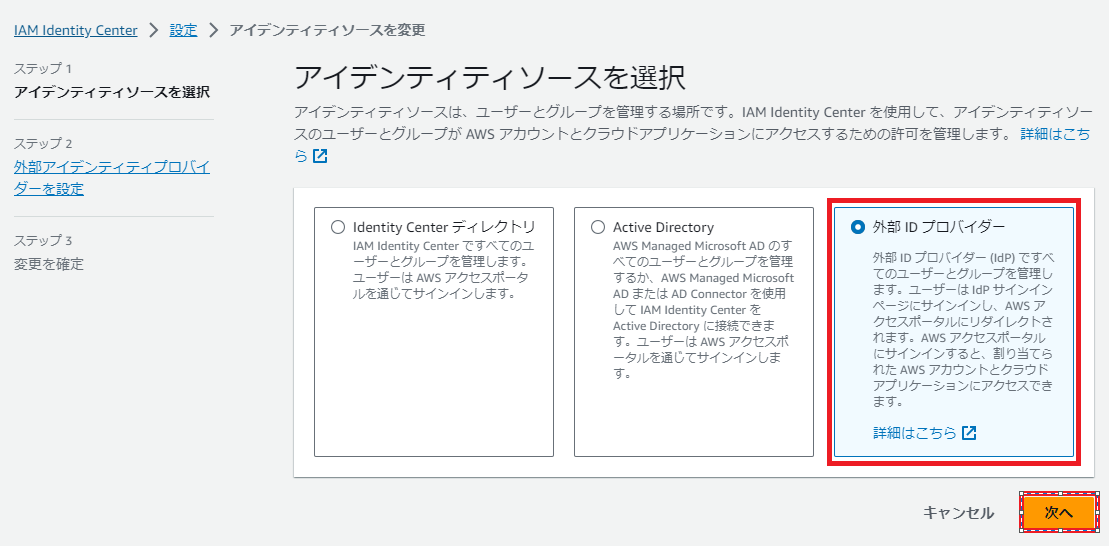

4-4.[アイデンティティソースを選択]で、[外部 ID プロバイダー]を選択し、[次へ]を選択します。

4-5.[外部アイデンティティプロバイダーを設定]ページが開きます。このページを完了するには、IAM Identity Center を Google Workspace で SAML アプリとして設定し、Google管理コンソールから情報を取得する必要があります。次の手順を実行します。

4-5-1.Google管理コンソールの左側のナビゲーションパネルで、[アプリ]を展開し、[ウェブアプリとモバイルアプリ]を選択します。

4-5-2.[アプリを追加]を選択し、[カスタム SAML アプリの追加]を選択します。

4-5-3.[アプリの詳細] ウィンドウで、以下のフィールドに入力します。

[アプリ名] : AWS access portal

[説明] : Google Workspace チュートリアル用の AWS アクセスポータル

[続行] を選択します。

4-5-4.[Google ID プロバイダの詳細]ページで 、[続行]を選択します。

4-5-5.[サービス プロバイダの詳細]ページで、 ACSのURLとエンティティ IDの値を入力します。 IAM Identity Center コンソールに戻って、次の値を確認します。

IAM Identity Center コンソールの「サービス プロバイダーのメタデータ」で、「IAM Identity Center Assertion Consumer Service (ACS) URL」 をコピーします。 Google管理コンソールに戻り、URL を[ACSのURL]フィールドに貼り付けます。

IAM Identity Center コンソールの[サービス プロバイダーのメタデータ]で、「IAM Identity Center 発行者 URL 」をコピーします。 Google管理コンソールに戻り、URL を[エンティティ ID]フィールドに貼り付けます。

4-5-6.Google管理コンソール-サービス プロバイダの詳細ページで、 [名前 ID]の下のフィールドに次のように入力します。

[名前 ID 形式] : EMAIL

[説明] : Basic Information > Primary email

[続行]を選択します。

4-5-7.[属性マッピング]ページ の[属性]で[マッピングを追加]を選択し、 Google Directoryの属性で次のフィールドを設定します。

[Basic Information]、[Primary Email] フィールドを選択し、[アプリの属性] に次のように入力します。 https://aws.amazon.com/SAML/Attributes/RoleSessionName

[Amazon]、[Role] フィールドを選択し、[アプリの属性] に次のように入力します。 https://aws.amazon.com/SAML/Attributes/Role

※Amazon、Role は、手順 1で作成したカスタム属性です。

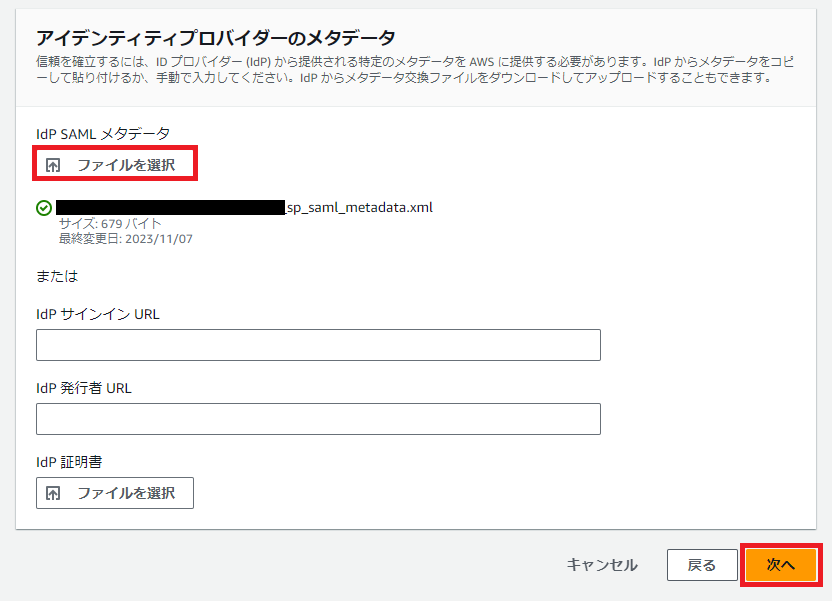

4-5-8.完了を選択してください

4-6.IAM Identity Center コンソールに戻り、「外部アイデンティティプロバイダーを設定」ページに移動します。[アイデンティティプロバイダーのメタデータ]の[IdP SAML メタデータ]で[ファイルを選択]を選択し、手順 2 でダウンロードしたGoogleIDPMetadata.xmlファイルをアップロードします。

[次へ]を選択します。

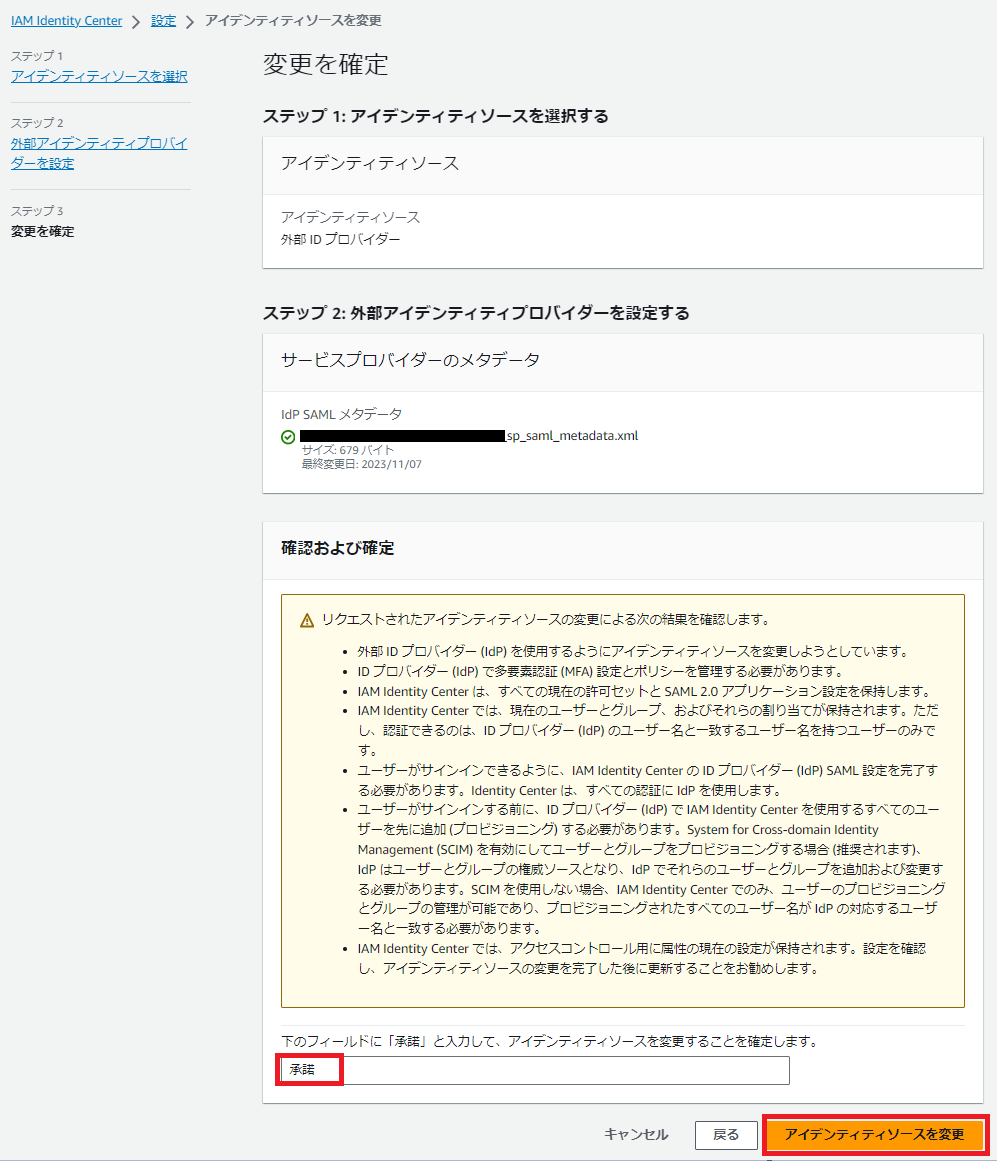

4-7.[変更の確認]ページで情報を確認し、表示されたスペースに「承諾」と入力し、[アイデンティティソースを変更]を選択します。

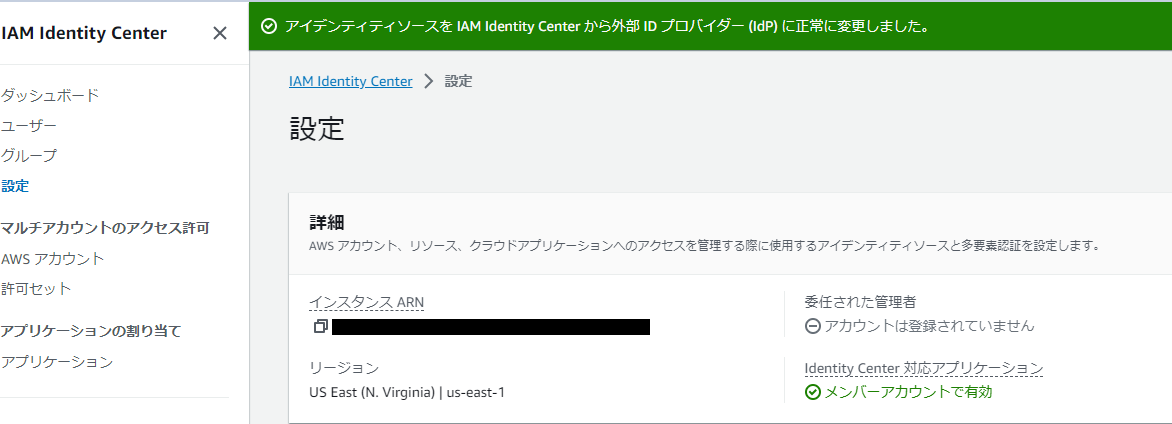

まとめ

これで、Google Workspace ユーザーを IAM Identity Center ユーザーとしてAWS 環境に同期する準備が整いました。

次回は実際にユーザーの同期を実施したいと思います。

お知らせ

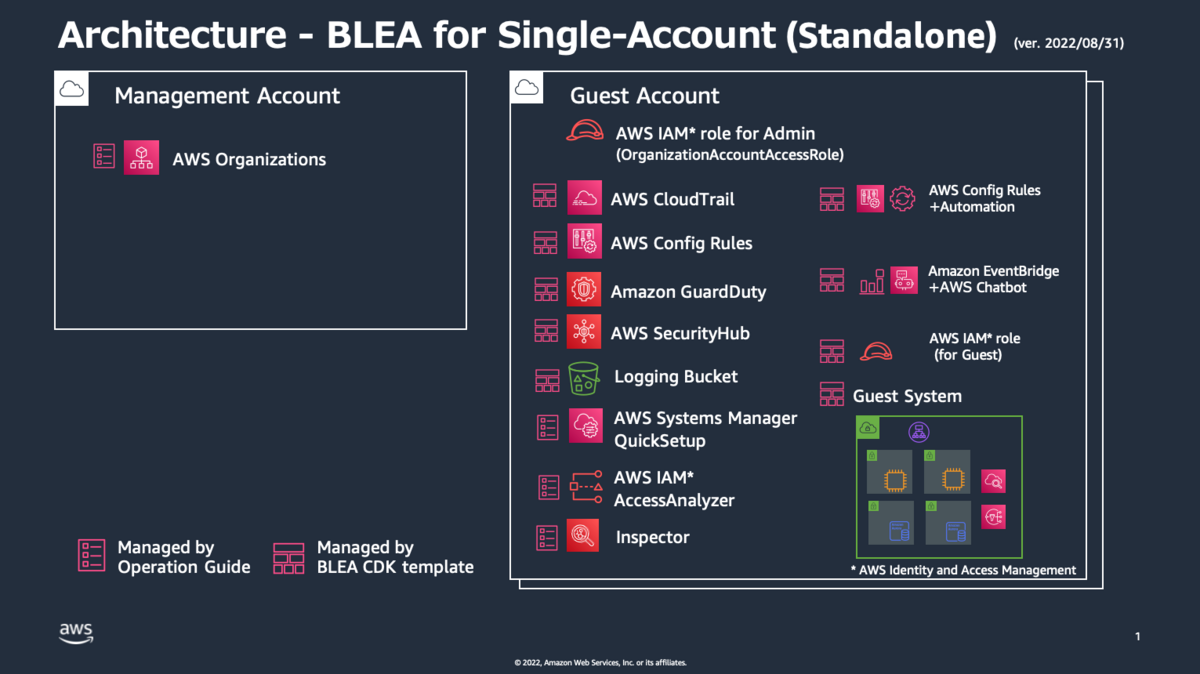

弊社はAWSアドバンスドティアサービスパートナー認定を受けております。また以下のようにAWSの活用を支援するサービスも行っているので、何かご相談したいことがあればお気軽にご連絡ください。

一緒に働いていただける仲間も募集中です!

今年もまだまだ組織規模拡大中なので、ご興味持っていただけましたらぜひお声がけください。