はじめに

GLB事業部Global Engineering部 ヨハンです。 現地でのData + AI SUMMIT2023(DAIS)に参加している市村の報告をもとに、セッションの内容をまとめた記事を書きました。

今回は、データガバナンスプログラムを実現するための取り組みについて紹介する講演「Increasing Trust in Your Data: Enabling a Data Governance Program on Databricks Using Unity Catalog and ML-Driven MDM」を取り上げます。この講演では、データガバナンスの重要性を強調し、具体的な事例を通してその実現方法を紹介しています。 本ブログは全2部構成で、今回は第2部をお届けします。第1部では、Comcastがデータガバナンスプログラムを実現するために取り組んでいる具体的な取り組みや、Databricks LakehouseアーキテクチャとUnity Catalogを使用したデータガバナンスの事例が紹介されました。 今回の第2部では、Comcastが構築したデータハブとデータレイクハウスの設計について解説し、データマッチングと機械学習ソリューションによるデータ信頼性向上の取り組みを紹介します。 それでは、早速見ていきましょう!

データハブとデータレイクハウスの設計

Databricks Lakehouseアーキテクチャを中心としたデータハブの構築

Comcastは、データと分析を活用したデジタルトランスフォーメーションを進める中で、Databricks Lakehouseアーキテクチャを中心としたデータハブを構築しました。このデータハブは、データガバナンスを考慮した設計がされており、データの信頼性を向上させることができます。 Databricks Lakehouseアーキテクチャは、以下のような特徴があります。

- データウェアハウスとデータレイクの機能を統合

- 高速なデータ処理と分析が可能

- 柔軟なデータストレージと処理が可能

これにより、データの一元管理が可能となり、データの品質や整合性を保つことができます。

データガバナンスを考慮したデータレイクハウスの設計とその3つのレイヤー(ブロンズ、シルバー、ゴールド)

データガバナンスを考慮したデータレイクハウスの設計では、データを3つのレイヤーに分けて管理します。それぞれのレイヤーは、以下のような役割を持っています。

- ブロンズレイヤー:生データをそのまま格納するレイヤー。データのバックアップやアーカイブの役割を果たします。

- シルバーレイヤー:ブロンズレイヤーからクレンジングや加工を行ったデータを格納するレイヤー。データの品質を向上させる役割を果たします。

- ゴールドレイヤー:シルバーレイヤーからさらに集計や分析を行ったデータを格納するレイヤー。ビジネスインサイトを提供する役割を果たします。

このようなレイヤー構造により、データの品質や整合性を保ちながら、効率的なデータ活用が可能となります。 また、データガバナンスプログラムを実現するために、Unity CatalogとML-Driven MDM(マスターデータ管理)を活用しています。これにより、データのメタデータ管理やデータ品質の向上が可能となり、データの信頼性を高めることができます。

データマッチングと機械学習ソリューションによるデータ信頼性向上

データガバナンスプログラムを実現するために、Comcastが取り組んでいるデータマッチングと機械学習ソリューションについて紹介します。

複数の距離メトリックを使用したデータポイント間の類似性の判断

データの信頼性を向上させるためには、データポイント間の類似性を正確に判断することが重要です。Comcastでは、複数の距離メトリックを使用して、データポイント間の類似性を判断しています。これにより、データの正確性が向上し、データガバナンスプログラムの効果が最大化されます。 具体的には、以下のような距離メトリックが使用されています。

- ユークリッド距離

- コサイン類似度

- ジャッカード係数

これらの距離メトリックを組み合わせることで、データポイント間の類似性をより正確に判断することができます。

データ正規化、クリーニング、およびCRMシステム内の重複データを解決する機械学習ソリューションの開発

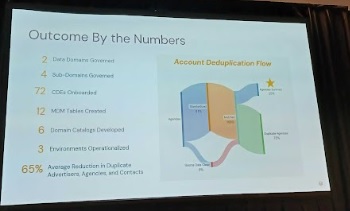

データの信頼性を向上させるためには、データの正規化やクリーニングが欠かせません。また、CRMシステム内の重複データを解決することも重要です。Comcastでは、これらの課題を解決するために、機械学習ソリューションを開発しています。 具体的には、以下のような手法が取り入れられています。

- データの正規化: データのスケールや単位を統一することで、データの比較や分析が容易になります。

- データクリーニング: データの欠損値や外れ値を処理し、データの品質を向上させます。

- 重複データの解決: CRMシステム内の重複データを検出し、統合することで、データの一貫性を保ちます。

これらの手法を組み合わせることで、データの信頼性が向上し、データガバナンスプログラムの効果が最大化されます。

まとめ

データガバナンスプログラムを実現するためには、データハブとデータレイクハウスの設計やデータマッチングと機械学習ソリューションが欠かせません。Comcastの取り組みを参考に、データの信頼性を向上させる方法を検討してみてください。データの信頼性が向上すれば、ビジネスの成長にも大きく寄与することでしょう。

おわりに

現地でのDAISに参加しているメンバーからの報告をもとに、セッションの内容を解説しました。 DAIS期間中では、セッションに関する記事を以下の特設サイトに順次上げていきますので、見ていただけると幸いです。

引き続きどうぞよろしくお願いします!