導入とケーススタディ概要

本セッションの登壇者は、Databricksのシニアプロダクトマネージャー、Jonathan Brideauです。Delta Lake、特にユニバーサルフォーマット、またはUniFormを中心にイニシアチブをリードしています。

Snowflakeのような従来のまたは独自のシステムからDelta Lake UniFormを使用したオープンデータレイクハウスアーキテクチャへの移行という一般的なシナリオを踏まえた紹介がされました。

Delta Lake UniForm

今回のセッションでのメインとなる Delta Lake UniForm は、データレイクハウスにおけるテーブルフォーマットの相互運用性を大幅に向上させるために設計されたユニバーサルフォーマットです。これにより、Apache IcebergやApache Hudiなどの他のテーブル形式を利用するクライアントでも、Deltaテーブルにアクセスできます。

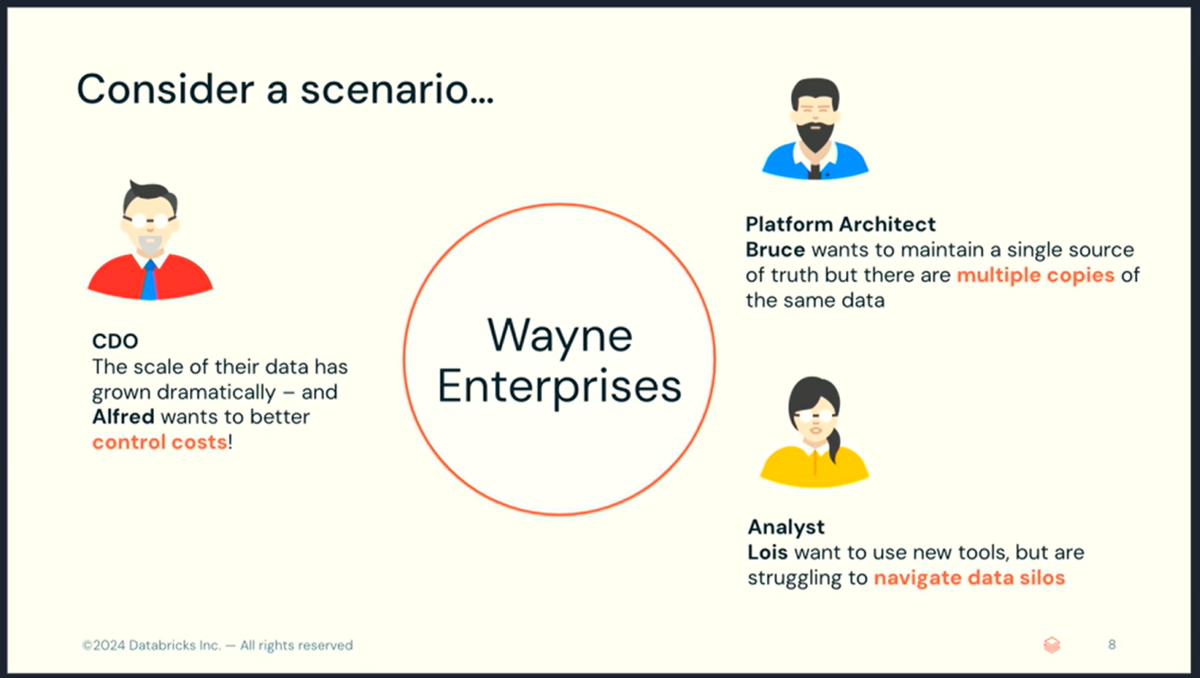

このセッションでは、Wayne Enterprises という架空の企業とシナリオに基づいて、Delta Lake UniFormの採用がDelta Lakeのエコシステムをどのように拡大させるかを掘り下げ、より広範なツールとの統合を可能にします。このユニークな機能により、一度保存されたデータは任意のサポートエンジン全体でアクセス可能になり、データアクセシビリティを最適化し、分析と運用プロセスの両方を簡素化します。

まず、独自のデータ形式に関連する差し迫った課題を特定し、Delta Lake UniFormを中心に構築されたオープンデータレイクハウスへの移行が、現代のデータ駆動型企業にとって戦略的であるだけでなく必要である理由を強調します。

課題とアーキテクチャの進化

Wayne Enterprise:シナリオと直面した課題

多くの組織が、Wayne Enterprises を含む、移行プロセス中に異なるプラットフォーム間でデータにアクセスし、統合する問題に遭遇します。 登場人物となる社員は、以下の様な役割を担っておりプラットフォームの移行プロジェクト検討しています。

- アルフレッド - チーフデータオフィサー (CDO)

- ブルース - プラットフォームアーキテクト

- ロイス - 主要アナリスト

アルフレッドの課題:

- データの規模拡大に伴うコストの急増。

- コスト抑制のためのプレッシャー。

- データ量の増加に比例してコストが指数関数的に増加する問題。

ブルースの課題:

- データの単一コピーを維持することの重要性。

- データプラットフォーム全体にわたる複数のテーブルコピーの存在。

- データの不整合や信頼性の問題。

- 追加のコピー作成に伴う計算資源とストレージのコスト増加。

ロイスの課題

- 異なるデータサイロをナビゲートする困難さ。

- 必要なデータが異なるプラットフォームに隔離されているため、アクセスが難しい状況。

- データからインサイトを得る際の多くの異なる声やチャレンジ。

移行シナリオ

- データレイクハウスからオープンデータレイクハウスへの移行についてのアーキテクチャを紹介。

- Wayne Enterprises がこの移行をどのように進めたかを具体的なストーリーとして展開。

このシナリオは、多くの企業が直面する一般的な問題を浮き彫りにし、このような状況がどのように発生するのか、どのような解決策があるのかという疑問を提起します。

現行アーキテクチャ

Wayne Enterprises におけるプラットフォームの現在のアーキテクチャは、基本となるアーキテクチャとさらに新しいユースケースに対応するために追加されたアーキテクチャのそれぞれが存在します。

基本アーキテクチャ: MySQL、システムログ、SalesforceからのデータをAmazon S3に格納し、Snowflakeでメダリオンアーキテクチャを使用してデータを階層化しています。BIレポート作成にはTableauを使用し、Snowflakeをサービングレイヤーとして活用しています。

新しいユースケース対応のための追加アーキテクチャ: 機械学習ユースケースに対応するためにDatabricksおよびLakehouse AIプラットフォームを導入し、ローカルデータ処理にはDuckDBを使用しています。これにより、柔軟で拡張可能なアーキテクチャを実現しています。

現行アーキテクチャの問題点

現在のクラウドアーキテクチャは、複数のデータソースとツールを中央で管理するようには設計されておらず、この見落としはしばしばデータサイロの問題につながりました。これらのアーキテクチャに対して、以下の様な問題点が取り上げられました。

データ処理コストの増大:

- データ量の増加に伴い、データのロードとETL(Extract, Transform, Load)プロセスがSnowflakeの請求額の約75%を占めるようになっている。

- ETLパイプラインにおける非効率(非効率なオートスケーリングや高価なクエリの再試行)が、アルフレッドが指摘するコストの急増の主な原因となっている。

データの複数コピーと不整合:

- Snowflakeの独自フォーマットにより、他エンジン(例:Databricks)で使用できず、結果的にデータの重複が発生。

- データの重複が多くの追加コストを生み出し、単一の一貫したデータソースの欠如やデータの不整合を引き起こし、複雑なアーキテクチャを生み出している。

- データウェアハウジングとデータサイエンスのために異なるスタックを維持する必要があり、追加のパイプライン管理が求められる。

データのサイロ化:

- Snowflakeの独自フォーマットにロックされたデータが多いため、ロイスが使用したい他のツール(例:DuckDB)へのアクセスが制限されている。

- 必要なデータが異なるプラットフォームに分散しているため、データのサイロ化が進行し、最適なツールを活用することが難しくなっている。

解決策の探求

現在のデータ管理問題につながったアーキテクチャ上の決定を検討することは、効果的な解決策を特定する上で重要です。Delta Lake UniFormなどの技術を実装することにより、さまざまなデータプラットフォーム間で統合データアクセスを可能にし、これらの課題を軽減することができます。

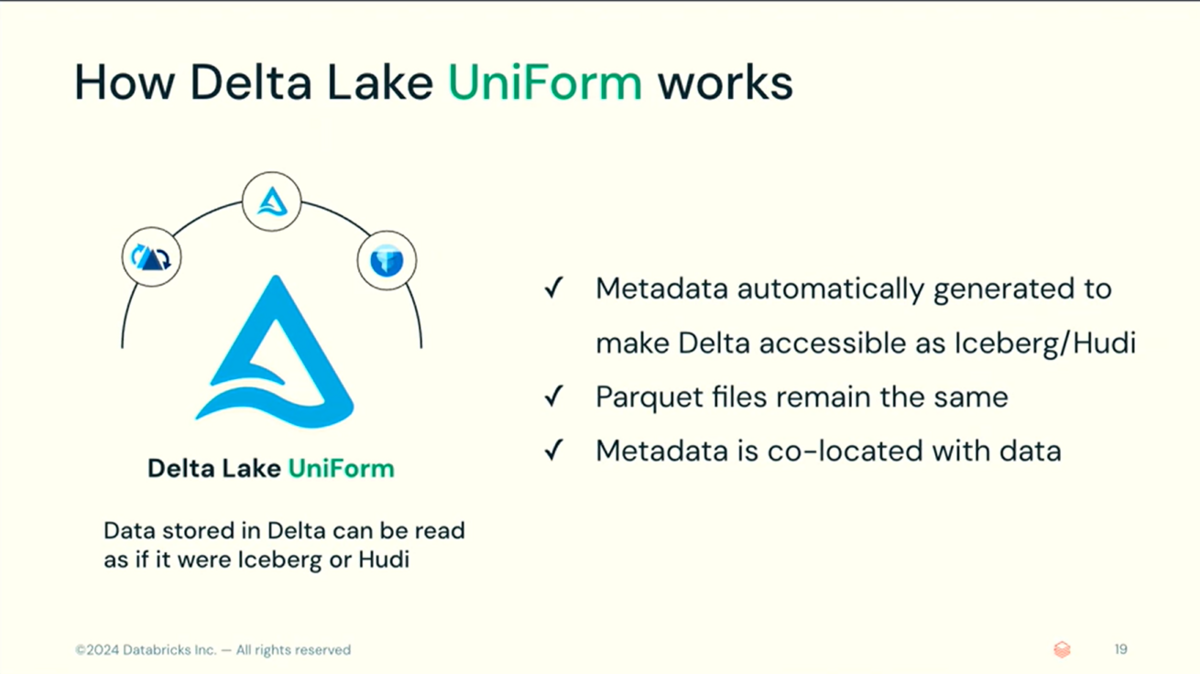

複数のオープンデータフォーマットに対応

統一されたデータコピーの作成:

- Delta Lake UniFormは、Delta Lake、Apache Iceberg、およびApache Hudiのメタデータを組み合わせ、単一のParquetファイルのコピーを維持します。

- これにより、異なるエンジンからアクセス可能なデータコピーが一つに統合されます。

自動メタデータ生成:

- UniFormは、Delta Lake、Iceberg、およびHoodieのメタデータを自動的に生成し、手動での変換を不要にします。

- メタデータの自動生成により、異なるフォーマット間でのデータの一貫性と整合性が保たれます。

複数エンジンからのアクセス:

- Snowflake:Icebergとしてデータを読み取り可能。

- Databricks:Deltaとしてデータを読み取り可能。

- DuckDB:新しいDeltaコネクタを通じてDeltaとしてデータを読み取り可能。

- これにより、異なるデータエンジン間でデータの整合性を維持しつつ、柔軟なアクセスが可能となります。

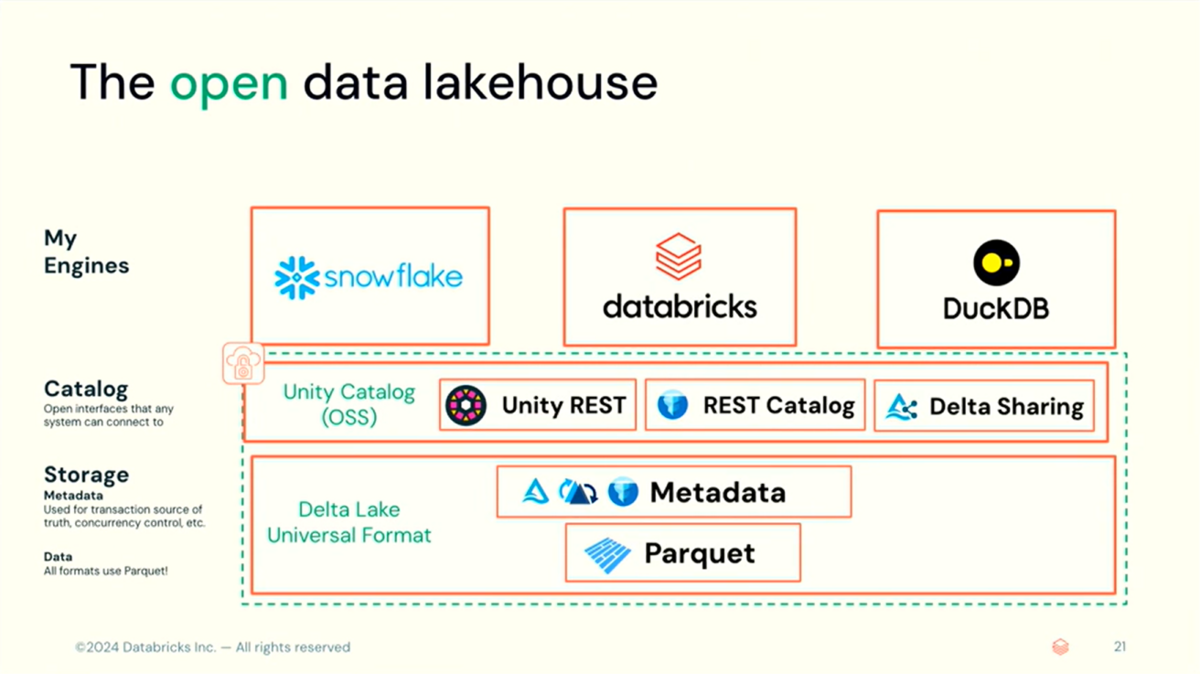

Unity Catalog によるガバナンス管理

統一されたガバナンス提供:

- Delta Lake UniFormは、オープンインターフェースを提供するUnity Catalogを使用します。

- Unity Catalogは、エコシステム内のどのエンジンでも接続できるように設計されており、統一されたガバナンスを提供します。

広範なエンジン互換性:

- Unity Catalogは、Iceberg RESTカタログの読み取り専用実装を持ち、Spark、Flink、Trinoなどの外部クライアントが接続できます。

- Delta Sharingを通じて、異なるコンピューティングプラットフォーム間で安全にデータを共有できます。

Delta Lake UniFormを使用してSnowflakeからオープンデータレイクハウスへ移行

新しいアーキテクチャの確立と設計

上述で紹介した Delta Lake UniForm とUnity Catalog を活用したオープンデータアーキテクチャの特徴は以下になります。

データソースと取り込み

- データソース:MySQLデータベース、システムログ、Salesforce。

- データ取り込み:Databricksを使用してデータを取り込み、Delta Lakeテーブルに変換。

データ処理と管理

- 変換プロセス:Databricks LakehouseでSparkとPhotonを使用してデータを変換。

- データの格納:データはカスタムのローストレージバケットに格納され、ブロンズ、シルバー、ゴールドレイヤーテーブルに書き込まれる。

- ETLプロセス:オートローダーやDelta Liveテーブルを使用してデータを効率的に取り込み、簡単なパイプラインを作成。

機械学習と分析

- 機械学習ワークロード:Databricks AIプラットフォームの全ツール群を使用。

- 統一されたレイヤー:データがオープンフォーマットでカスタマーバケットに保存され、さまざまなエンジン(Snowflake、DuckDB)からアクセス可能。

Delta Lake UniFormを導入した新しいアーキテクチャは、データの管理と分析において統一されたレイヤーを提供します。

これにより、従来のデータウェアハウジング用とデータサイエンス用の2つの別々のスタックを持つ必要がなくなり、統一されたレイヤーを通じてBI、AI、MLの処理を一元化できます。

この統一されたレイヤーにより、データの取り込み、変換、保存が効率化され、データの一貫性と整合性が維持されます。

新しいアーキテクチャのメリット

Wayne EnterprisesがSnowflakeからDelta Lake UniFormへの移行によって次世代アーキテクチャの構築において目標をどのように達成できるかについて議論します。

主に以下のトピックに基づいた詳細な議論があります:

- コストとパフォーマンスの最適化:Delta Lake UniFormへの移行により、データ処理コストを大幅に削減しました。Databricksの利用により、データのロード速度が向上し、コストもSnowflake管理のIcebergテーブルよりも大幅に安価になりました。具体的には、Databricksが6倍速くデータをロードできるだけでなく、コスト面でもSnowflakeの10分の1に抑えられました。また、ETLプロセスが効率化されました。ETLベンチマークにおいても、DatabricksのUniFormがSnowflake管理のIcebergテーブルよりも1.5倍速く、パーティショニングなどの基本機能をサポートしているため、より現実的で効率的なデータ処理が可能となりました。

- 集中データ管理:Delta Lake UniFormを活用し、さまざまなエンジン(Snowflake、DuckDB)での書き込みと読み取りのユーザージャーニーを検証しました。このプロセスにより、データの重複を排除し、統一されたレイヤーでのデータ管理が可能となりました。具体的には、メダリオンシステムのGoldレイヤーにおいて、Icebergクライアントと共有するテーブルにUniFormを適用し、下流のBIや分析ワークロードに対応しました。UniFormを有効にするための設定は非常に簡単で、Delta Lakeテーブルの作成時に必要なIcebergメタデータのプロパティを追加するだけで、手動での変換は不要です。これにより、データの重複が減少し、下流のエンジンでの読み取りがシームレスに行えるようになりました。

- ツールアクセス権:新しいアーキテクチャでは、Databricksを使用してデータを一度書き込み、ETLを実行することで、データの単一コピーを保持しつつ、複数のエンジンからアクセスできるようにしました。これにより、データのサイロ化が解消されました。具体的には、データをDelta Lakeに保存し、UniFormを適用することで、データが一貫して管理され、SnowflakeやDuckDBを含むさまざまなエンジンからアクセス可能となりました。また、Python、Rust、Javaなどのさまざまなエコシステムやプラットフォームを網羅する豊富なコネクターエコシステムが活用できるようになりました。これにより、現在および将来のツールにアクセス可能となり、必要な柔軟性とセキュリティが確保されました。

これらの目標に基づき、次世代データアーキテクチャの設計はWayne Enterprisesのデータ管理効率を大幅に向上させ、ビジネス成長を加速する可能性があります。データの利用可能性と操作性を高めることは、分析の精度を向上させるだけでなく、新たな洞察の発見を促進します。

ガバナンスと実装

データレイクハウスの設定における「ガバナンスと実装」に焦点を当て、単なるデータストレージを超えてカタログ管理を含むDelta Lake Universal Format(UniForm)の使用を拡張します。

データ移行の簡素化: UniFormの展開により、アーキテクチャ内の任意のツールとの統合を可能にしながら、データを一度だけ保存できます。この方法は、手動でのデータ変換の必要性を排除し、データ重複のリスクを最小限に抑え、全体的なデータ管理の効率を向上させます。

メタデータの共存: メタデータは重要な役割を果たし、データ自体と同じ環境(例えばS3バケット内)に位置します。この設定では、Delta Log と Iceberg のメタデータのディレクトリが並行して維持されます。この共置は、使用される分析エンジンの選択に関わらずシームレスなアクセスを保証します。

Unity Catalogの提供: カタログの確立は、Delta Lakeのレイクハウスアーキテクチャのガバナンスと実装において重要なコンポーネントです。これは、さまざまなエンジン全体で一貫したポリシーの適用を保証し、統一されたガバナンスを提供します。しかし、組織の戦略的ニーズを適切に満たすためには、適切なカタログの選択を慎重に行う必要があります。

このセクションは、技術的データ変換を合理化し、重複を避けるための効果的な戦略を概説しており、データガバナンスと管理へのより効率的なアプローチを促進します。Delta Lake UniFormがこれらのプロセスを可能にする技術的なメカニズムを強調し、多様なデータエコシステムでの効率的な運用を保証します。

Databricks AIプラットフォームで利用可能なツールを活用し、Delta Lake Universal Format(UniForm)を使用することで、SnowflakeやDuckDBを含むさまざまなエンジンでのアクセシビリティを保証しながら、データを中央で保存することが実現可能になります。このアプローチにより、データウェアハウスとデータサイエンス専用の複数の別個のスタックを必要とすることなく、BI、AI、MLのワークロードを効果的にサポートする統一されたレイヤーを作成します。

主なアーキテクチャの目標の一つは、データ量の増加に伴ってコストを効率的にスケールすることでした。この目標は、Snowflake内でデータのローディングとETLプロセスにしばしば遭遇する課題に対処することによって成功裏に達成され、最終的に大幅なコスト削減につながりました。顧客固有のバケットでオープンフォーマットで保存されたデータは、異なるエンジン間でのアクセスと利用を簡素化し、運用を合理化します。

Delta Lake UniFormを使用した管理されたデータレイクハウスへの移行は、データの取り扱いを最適化するだけでなく、コスト効率とパフォーマンスを大幅に向上させます。顕著な利点の一つは、多様な分析ツール間でのシームレスな統合とナビゲーションであり、これによりITインフラの複雑さが大幅に削減されます。

このセクションの議論から、重要なポイントは、さまざまなデータソースとツールにアクセスするために単一のデータフォーマットを効果的に使用することにより、企業がより柔軟で強力なデータ戦略を進めることができるということです。この戦略的アプローチは、初期セッションの目標とよく一致し、データ集約環境でのコスト効果的なスケーラビリティと運用効率の向上を保証します。

未来を見据えた活用と広範なユースケース

このセクションでは、Delta LakeのUniversal Formatをデータ管理の将来へのビジョンの一部としてどのように位置づけるかに焦点を当てています。特に、Unity Catalogの統合が強調されています。Unity Catalogは、Iceberg REST Catalog APIエンドポイントを通じてUniversal Formatテーブルを公開します。Iceberg REST Catalogは、Icebergが要求するカタログの抽象化を特徴としています。つまり、どのカタログバックエンドを使用していても、これらのテーブルは共通のオープンAPIを介して公開されることが可能です。その結果、どのIcebergリーダーも同じインターフェースとやりとりすることができます。Unity Catalogはすでにこの機能をサポートしており、Snowflakeに接続可能です。

この技術進歩が将来の保証をどのように向上させ、様々なユースケースをどのように想像できるかを示しています。データレイクからレイクハウスへの移行は、単なるテクノロジーの移転以上のものを意味します。それは、データの柔軟性とアクセシビリティを最大限に高め、企業がデータをより戦略的に利用することを可能にすることを体現しています。

Databricks Data + AI Summit(DAIS)2024の会場からセッション内容や様子をお伝えする特設サイトをご用意しました!DAIS2024期間中は毎日更新予定ですので、ぜひご覧ください。

私たちはDatabricksを用いたデータ分析基盤の導入から内製化支援まで幅広く支援をしております。

もしご興味がある方は、お問い合わせ頂ければ幸いです。

また、一緒に働いていただける仲間も募集中です!

APCにご興味がある方の連絡をお待ちしております。