イントロダクション

皆さん、こんにちは。本セッションでは、「RayとPineconeを利用したRAGと埋め込み計算のスケーリング」について探求します。本日は、検索拡張生成(RAG)、ベクターデータベース、埋め込み技術、およびこれらの技術を効率的にスケーリングする方法とコスト削減について深く掘り下げます。

本日のスピーカーは、PineconeのエンジニアリングマネージャーであるRianとRoyです。RoyはPineconeに2年間所属しており、ChatGPT登場前のAI時代からの豊富な経験を持ちます。彼のバックグラウンドはデータエンジニアリングおよびMLエンジニアリングで、SparkやDBTなどの技術に焦点を当てています。

同じく参加するのは、AnyScaleのデータチームのエンジニアリングマネージャーであるCheng Suです。Chengは以前、Metaのデータインフラストラクチャ組織に所属し、SparkやHadoop関連プロジェクトを扱っていました。

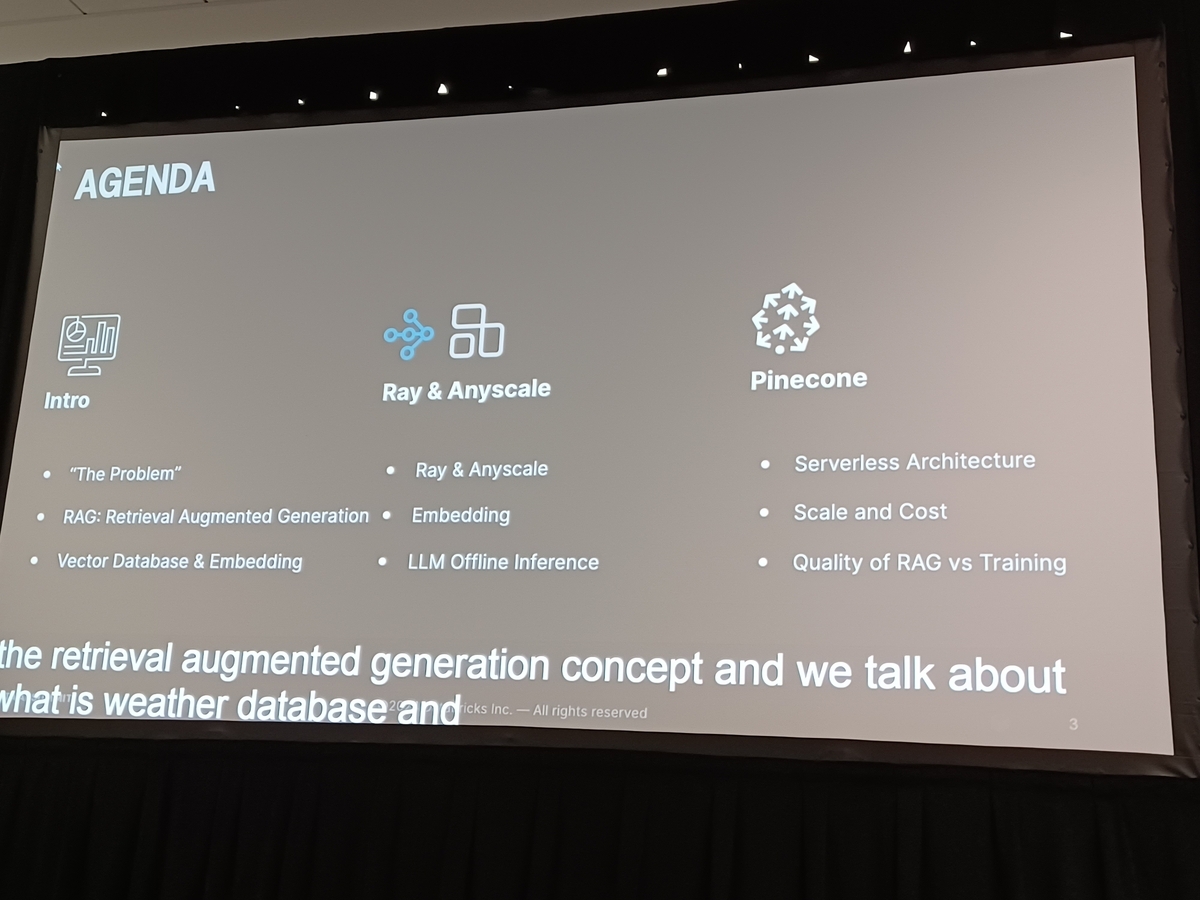

アジェンダは、彼らが取り組んできた問題についての紹介から始まります。最初のスライドでは、RAGが何であるか、ベクターデータベースとは何か、そしてエンベディングの本質について説明します。また、大規模なRAG評価のための動機を簡単に概説します。

このセッションは、RAG技術およびそのスケーリング方法を深く理解することを目的としており、参加者が自身のプロジェクトや研究にこの知識を応用できることを期待しています。さあ、このセッションの詳細についてさらに詳しく見ていきましょう。

セクション:埋め込み計算とLLMの幻覚

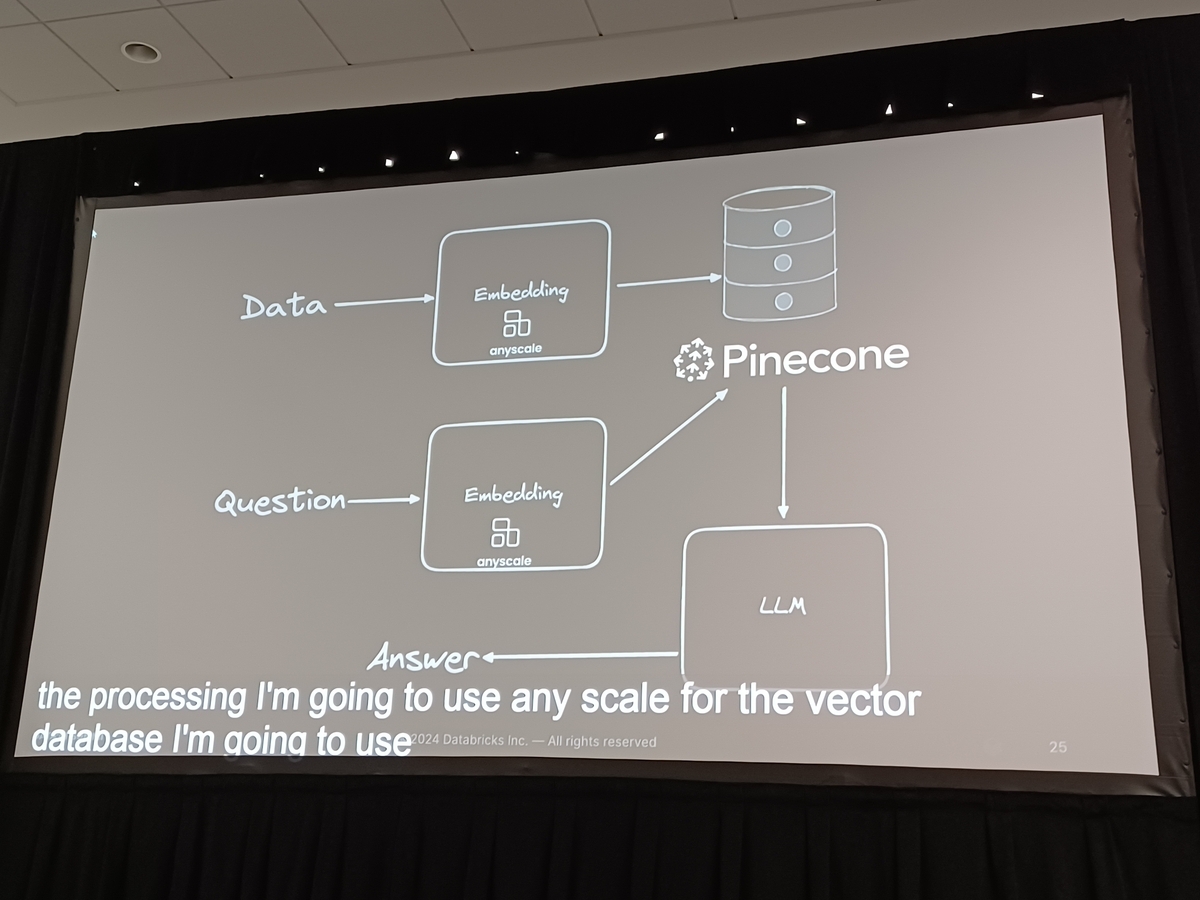

このセクションでは、データの前処理のプロセスと、Rayを使用して埋め込みを計算する方法について掘り下げます。データが埋め込まれると、バッチでアップロードされ、Pineconeサーバーにインデックスが付けられます。さらに、その効果を確認するために、データに対して包括的な検索拡張生成(RAG)が実行されます。

RoyはRECについて明確な説明を提供し、次のように述べています。「検索評価計算は、訓練目的ではなく、言語モデルに効果的にデータを供給するために設計されています。」彼は、「大規模言語モデル(LLM)における幻覚」として知られている重大な問題に対処し、これらのモデルがその知識ベースのギャップによって誤ったまたは根拠のない回答を生成する可能性があると指摘しています。Royは、RAGがモデルの応答を事実的で正確なデータに基づいて確実にすることで、重要な役割を果たしていると強調します。これは実用的なアプリケーションの開発に役立つだけでなく、LLMの分野での継続的な研究を支援します。

このセッションを通じて、多くの技術的詳細と実用的なユースケースが提示され、参加者にとって重要な洞察が提供されました。RayとPineconeを利用した手順は、最適なデータアクセス環境の設定方法を生き生きと示しており、これは堅牢な実世界のアプリケーションの作成だけでなく、LLMのドメインにおける研究の進展にも不可欠です。

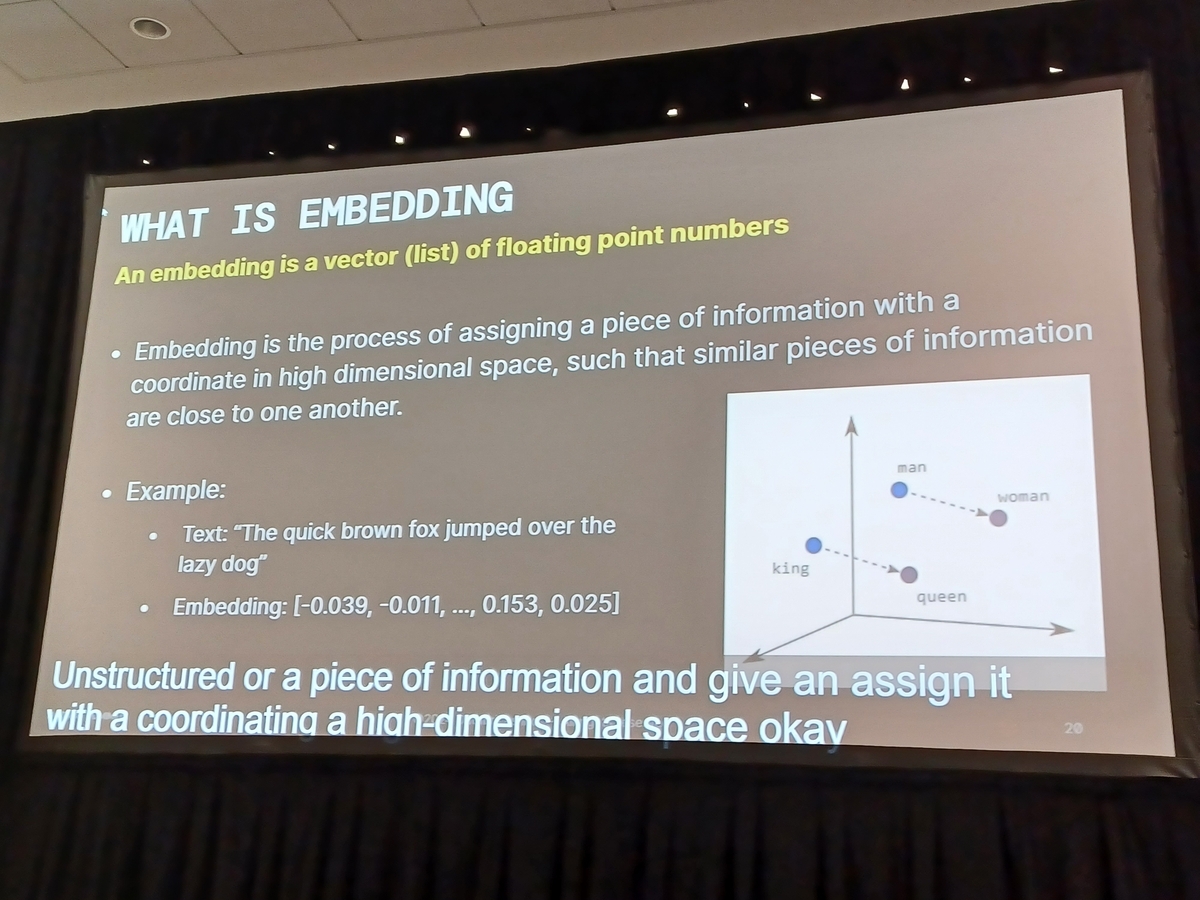

ベクターデータベースは、埋め込みを管理する能力のおかげで、人気が急上昇しています。埋め込みは、非構造化データや特定の情報を高次元空間内の座標として表現する変革的な方法として機能し、医療記録、法的文書、企業の年次報告書など、さまざまなデータタイプに適用可能で、データの取得と処理の効率と速度を向上させます。

「Scaling RAG and Embedding Computations with Ray and Pinecone」というセッションでは、大規模言語モデル(LLM)アプリケーションがベクターデータベースを利用することでコスト効率を高める方法について議論が集中しました。運用フローは、クエリを取り、それを埋め込みモデルで処理してベクターデータベースから関連データを取得し、モデルが正確で迅速な反応を生成できるようにします。この合理化されたアプローチは、データ処理とAIの最先端の実践を示し、埋め込みとベクターデータベースの間の相乗効果的な関係を強調し、コスト効果的な解決策を提供します。

データとAI技術の未来の軌道は、ベクターデータベースの持続的な進歩によって大きく影響を受けると思われます。これらのデータベースが進化するにつれて、私たちの情報処理と解釈の方法はより洗練され、速く、正確になることが期待されます。この進行は、企業や研究者がこれらの技術的進歩に遅れずに追いつき、進化する環境を効果的に活用するための重要な必要性を強調しています。

AnyScaleのAIプラットフォームと「Read Data」ライブラリに焦点を当てる

1. 分散レイヤーとしてのRAGの呼び出し

Retrieval Augmented Generation(RAG)は、さまざまな種類の分散計算を処理するための重要な分散レイヤーとして機能します。この能力は、広範なデータセット全体でリアルタイムに情報を検索し生成することを容易にするため、非常に重要です。

2. AnyScaleライブラリの統合

RAGレイヤーの上に、AnyScaleはいくつかの不可欠なライブラリを開発しました。これには、効率的なデータ処理のための「Read Data」、分散モデルトレーニングのための「Retrain」、詳細なハイパーパラメータチューニングのための「Tune」、機械学習モデルを強化するための「Reinforce Learning」、そしてモデル提供を簡素化するための「Re-serve」が含まれます。これらのライブラリは、AWS、Google Cloud、Microsoft Azureなどの主要なパブリッククラウドプロバイダーと互換性があります。

3. 「Read Data」ライブラリの活用

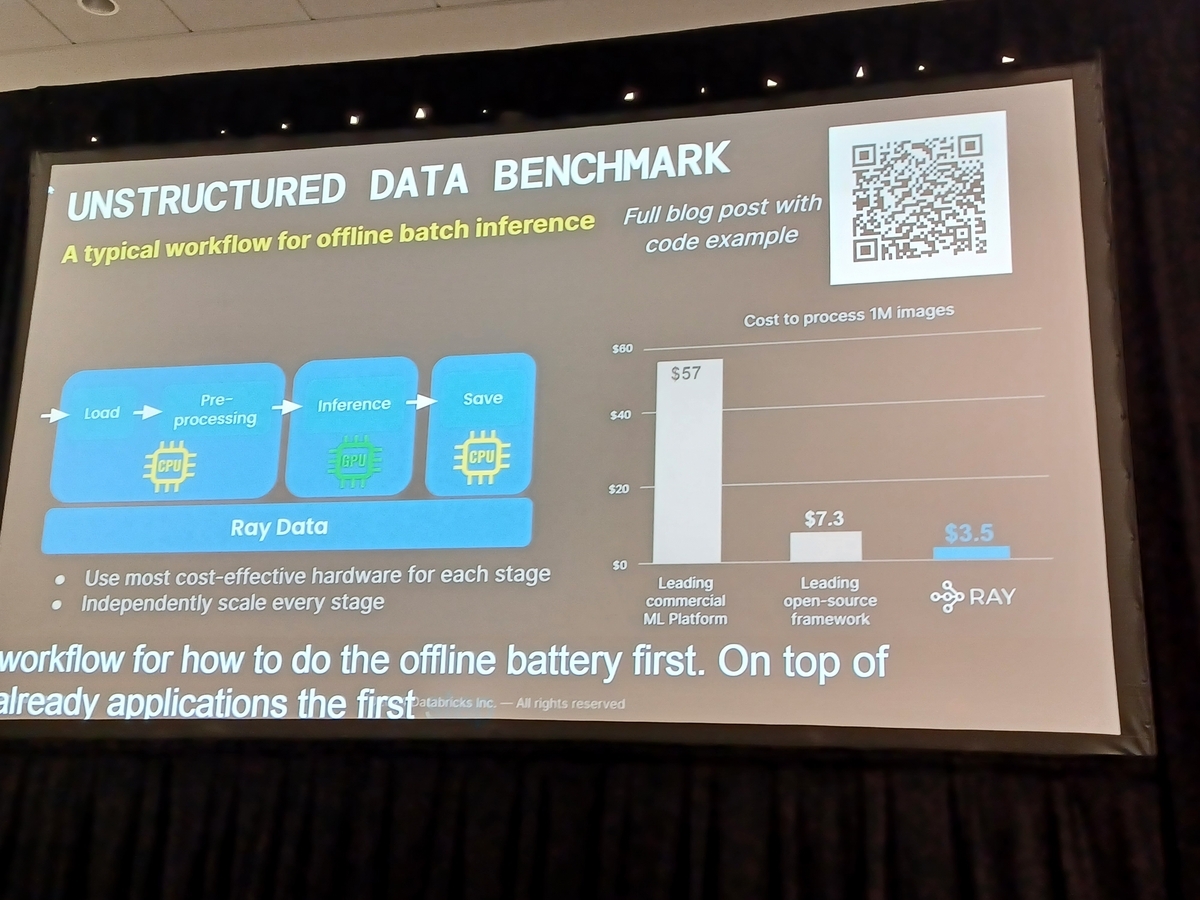

「Read Data」ライブラリは、機械学習のワークフローでスケーラブルなデータ処理のために特別に設計されています。その主な用途は「オフラインバッチ推論」です。これは、事前訓練されたまたは順次モデルを使用して、膨大な量のオフラインデータに推論を行うことを含みます。この広範なデータセットを活用することで、ユーザーはさまざまなアプリケーションでモデルの有用性を最適化できます。

このセグメントは、AnyScaleのAIプラットフォームの「Read Data」ライブラリが、特にオフラインバッチ推論の用途で、技術的にユーザーをどのように力強く支えるかを詳述しています。それは、大規模なデータセットを効率的かつ非リアルタイムで扱うライブラリの有効性を強調し、大規模なデータ処理の文脈でのその重要性を示しています。

エンベディング処理プロセスは、以下の4つの重要なステップに分けられます。

データの読み込み: 我々は、テラバイトからペタバイトに及ぶデータ規模と様々なデータ形式を含む巨大なクラウドストレージから入力データの読み込みを開始します。この文脈で注目すべきデータセットは、TIIによって作成された「PyCon RefinWeb」で、1.6テラバイトのデータを含んでいます。一見すると控えめに見えるかもしれませんが、その規模と計算要求はかなりのものです。

モデルを使用したエンベディング: データを扱いやすい形式に変換するために、1ビットエンベディングに特化したGTLargeモデルを使用し、データ変換を効率的に行います。

計算リソースの利用: エンベディング計算とPyConサーバーへのデータ統合の複雑なプロセスには、320のAWS G5インスタンスを使用します。これらのインスタンスはGPUを装備しており、堅牢な計算ニーズを扱うための費用対効果の高いかつ強力な解決策を提供します。

エンドツーエンドの処理時間: データの読み込みからエンベディング、そして最終的にサーバーへのデータアップロードまでの全プロセスは、およそ18時間で完了します。

この詳細な洞察は、PyConのサーバーレスアーキテクチャにおいて、データの読み込みからサーバー統合までの各ステップがいかに緻密に構築されているかを明らかにします。このセッションはまた、大量のデータ操作を伴う他のプロジェクトやアプリケーションにこれらの方法論をどのように外挿できるかを強調し、同様の将来の取り組みにとって貴重な参考となります。

こんにちは皆さん!最近の「Scaling RAG and Embedding Computations with Ray and Pinecone」というセッションから、特にRetrieval Augmented Generation(RAG)のスケーリングとパフォーマンス指標を中心に興味深いポイントを共有したいと思います。

RAGと非RAG実装の比較

まず、セッション中にRAGを使用した場合と使用しなかった場合のパフォーマンスの結果が強調されました。RAGが実装されていない場合、GPT 3.5やMixtralなどの主要な言語モデル間でパフォーマンス指標の顕著な違いが観察されました。しかし、この差はRAGが導入されることでほぼ解消され、0.71から0.72へと変わりました。これは、RAGを統合することがパフォーマンスの不均衡を埋めることにどのように影響を与えるかを示しています。

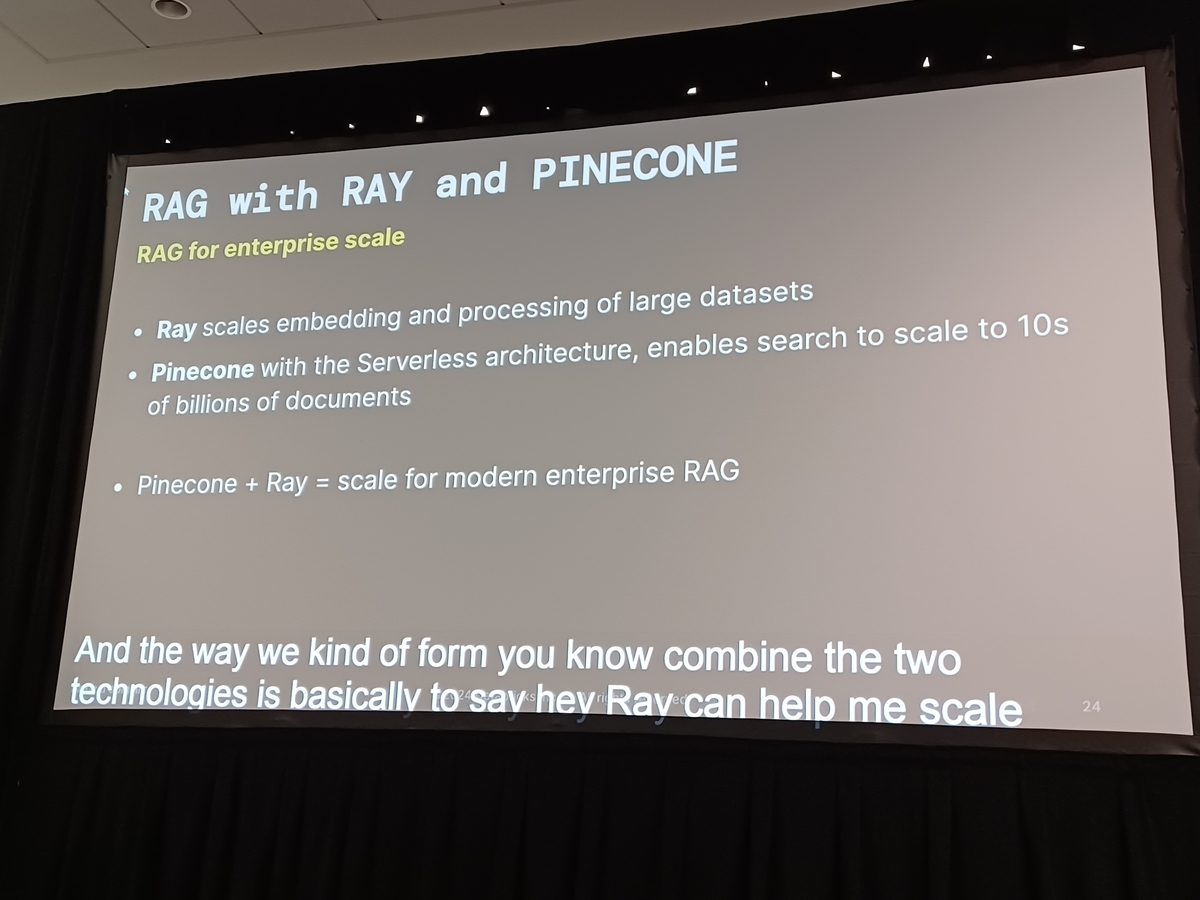

RAGを使用したスケーリング

RAGを使用してエンベディングをスケーリングすることについて、綿密に議論されました。セッションでは、データの取り扱い、ローディング、およびPineconeのベクターデータベースへの転送に関わるプロセスが詳述されました。RAGの利用は、大規模なエンタープライズグレードのシステムの構築を容易にします。Pineconeの実装により、大規模なサーバーレスアプリケーションの実現が可能になり、システム全体の効率が向上しました。

このセッションは、RAGの重要な役割を明確にし、それを効果的にスケーリングするための戦略的な方法を概説しました。このような技術的進歩を受け入れ、新しい洞察を統合することは、将来のプロジェクトにとって不可欠です。

皆さんには、これらの革新的な戦略を自分の事業や研究努力にどのように実装できるかを検討していただきたいと思います。今後の討論で皆さんと交流できることを楽しみにしています!

概要

このセッションでは、RayとPineconeを使用してRAG実装を効果的にスケーリングするための重要なコンポーネントを検討しました。Pineconeをベクターデータベースとして統合することで、データエンベディングプロセスの効率が大幅に向上します。この高度なセットアップは、エンベディング計算を加速するだけでなく、RAGアプリケーションにおける広範なデータセットの管理を合理化します。RAGの技術進歩により、開発者や研究者は大規模な言語モデルの機能を拡張する新たな可能性を開くことができます。これらの洗練されたツールと方法論を活用し続けるにつれて、AIおよび機械学習アプリケーションの可能性はますます広がり、期待されるものとなっています。

Databricks Data + AI Summit(DAIS)2024の会場からセッション内容や様子をお伝えする特設サイトをご用意しました!DAIS2024期間中は毎日更新予定ですので、ぜひご覧ください。

私たちはDatabricksを用いたデータ分析基盤の導入から内製化支援まで幅広く支援をしております。

もしご興味がある方は、お問い合わせ頂ければ幸いです。

また、一緒に働いていただける仲間も募集中です!

APCにご興味がある方の連絡をお待ちしております。