DSPy 3.0登場:プロンプトエンジニアリングを「職人技」から「ソフトウェア工学」へ

LLM(大規模言語モデル)を使ったアプリケーション開発において、多くの開発者が「プロンプトエンジニアリング」という複雑で終わりの見えない作業に直面しています。まるで魔法の呪文を唱えるかのように、モデルごとに異なる言い回しやフォーマットを試行錯誤する日々。この状況は、果たして持続可能なのでしょうか。

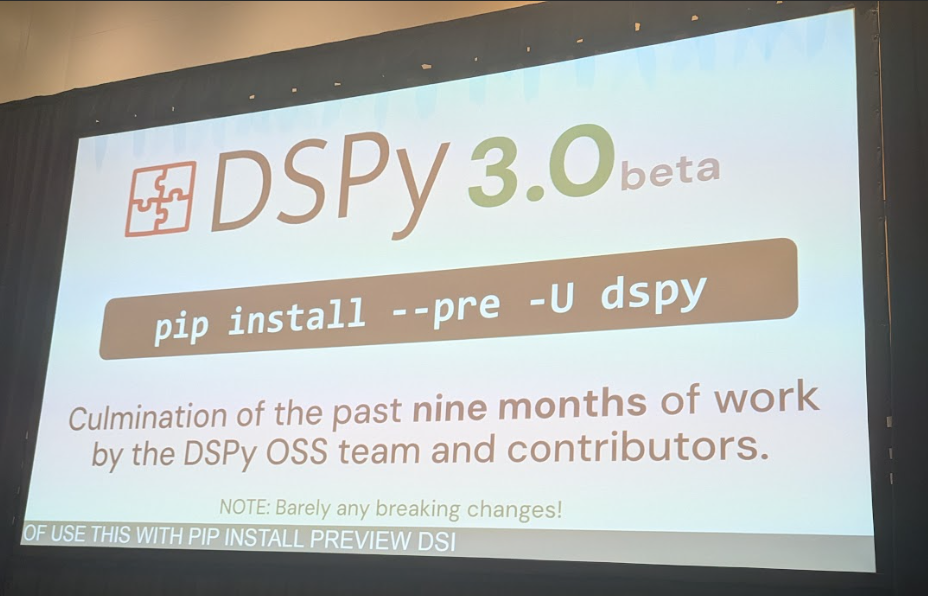

先日開催されたセッション「DSPy 3.0 — and DSPy at Databricks」で、DatabricksのリサーチサイエンティストでありDSPyの創設者でもあるOmar Khattab氏が、この根深い課題に対する強力なソリューションとして「DSPy 3.0」を発表しました。本記事では、同氏の講演内容と関連リサーチをもとに、DSPyがどのようにLLM開発のパラダイムを変えようとしているのかを詳しく解説します。

プロンプトという名の「混沌のスープ」

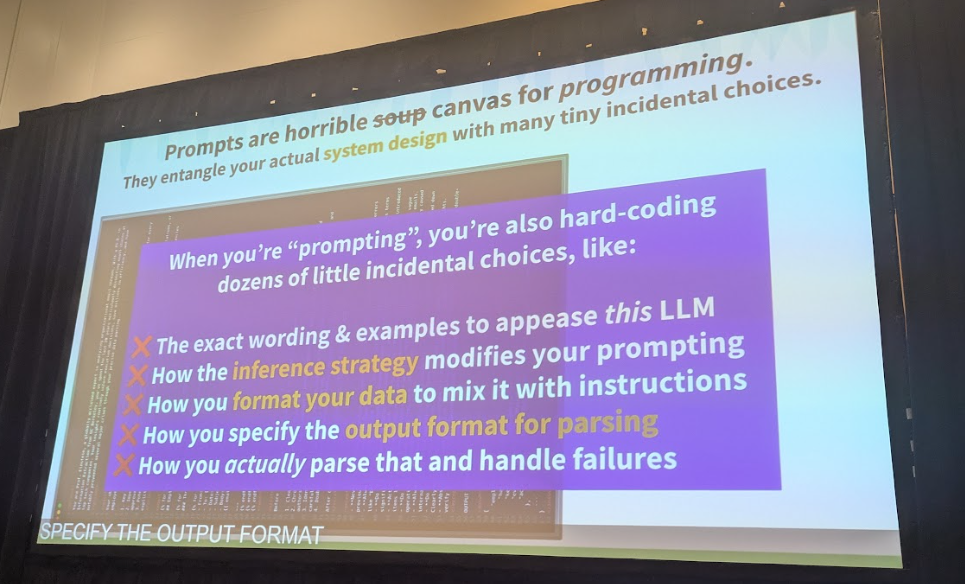

Khattab氏は講演の冒頭で、現代のLLM開発が抱える問題を鋭く指摘しました。新しいモデルが登場するたびに増え続けるプロンプトガイド、モデルごとの細かな「クセ」、そして「深呼吸してください」「アインシュタイン教授になりきって」といった、およそ技術仕様とは思えないようなテクニックの数々。

これらの試行錯誤の末に生まれるのは、Khattab氏が「sloppy prompt soup(混沌としたプロンプトのスープ)」と表現する、メンテナンス不能な巨大な文字列です。この「スープ」の中では、本来分離すべきアプリケーションのロジック、データ形式、推論戦略、そしてモデルをなだめるための呪文がすべてごちゃ混ぜになっています。これでは、モデルを新しいものに交換するだけで、すべてが壊れてしまう可能性があります。

これは、かつてソフトウェア開発者が「goto文」に依存していた時代に似ています。プログラムの流れが複雑に絡み合い、誰もその動作を正確に把握できなくなるのです。この問題の解決策は、コンパイラのような高レベルな抽象化によって、開発者が「何をしたいか」を宣言し、「どのように実行するか」はシステムに任せることでした。DSPyは、まさにこのアプローチをLLM開発の世界に持ち込もうとしています。

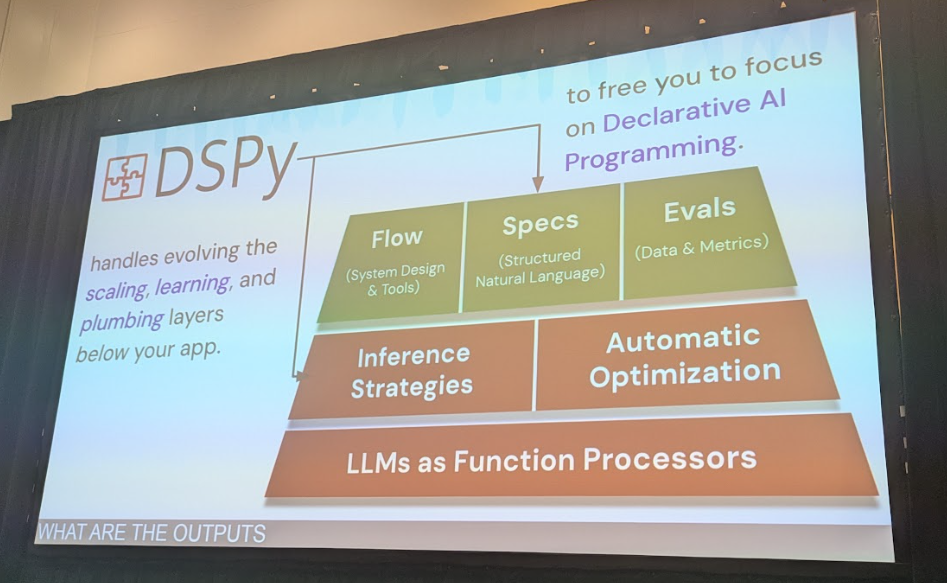

DSPyの核となる3つの抽象化

DSPyは、プロンプトの詳細を意識することなく、LLMアプリケーションを構築するためのフレームワークです。その中心には、LLMプログラミングを構造化するための3つの強力な概念があります。

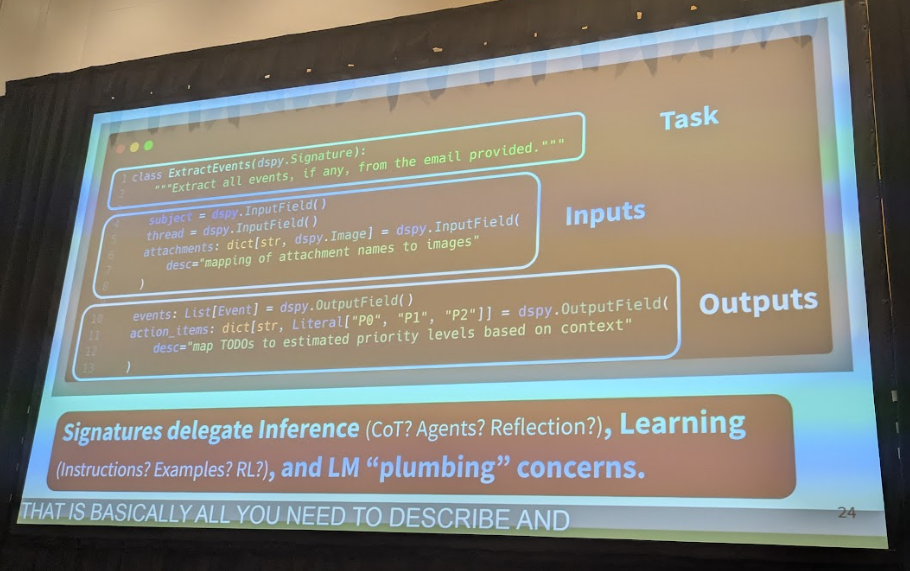

Signatures(シグネチャ): タスクの「何を」を定義します。これは、関数の型定義に似ています。入力フィールド(例:メールのスレッド、添付ファイル)と出力フィールド(例:イベント名、優先度)を宣言的に記述します。これにより、プロンプトの具体的な文言やJSONフォーマットといった実装の詳細から、タスクの本質的な「入出力の契約」を分離できます。

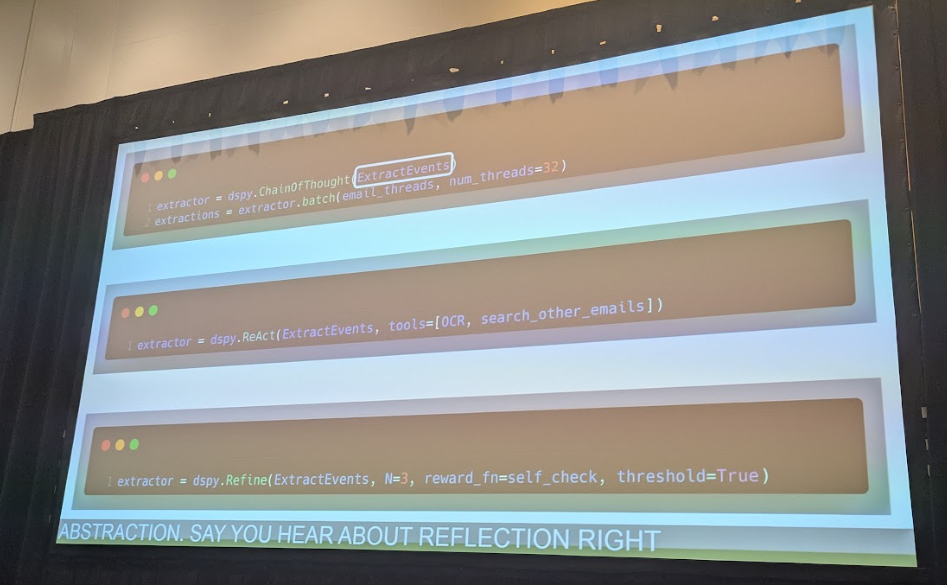

Modules(モジュール): タスクを「どのように」解くかを定義します。これは、推論戦略をカプセル化した再利用可能なコンポーネントです。例えば、Chain of Thought(思考の連鎖)や、複数のツールを使いこなすAgentといったモジュールに、先ほど定義したSignatureを渡すだけで、高度な推論ロジックを実装できます。

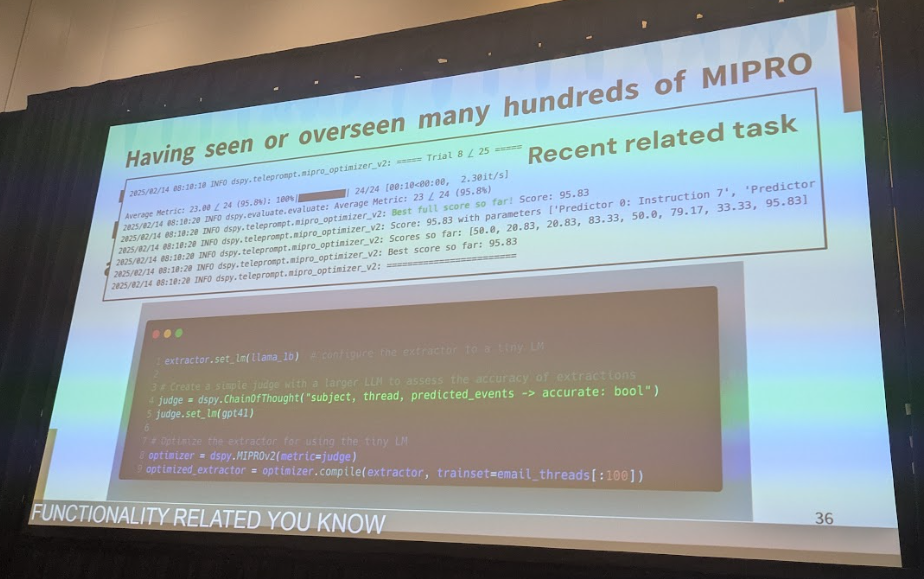

Optimizers(オプティマイザー): プログラム全体のパフォーマンス向上を支援します。ユーザーが用意したサンプルデータと評価指標をもとに、プロンプトの設計パラメータやfew-shot例の選定・調整をサポートします。さらに、必要に応じてファインチューニングAPIを利用し、モデルの重み更新も行えます。

この3つの概念により、開発者はアプリケーションのロジック設計に集中できます。LLMのモデルをGPT-4からLlama 3に切り替えても、コードの大部分は変更する必要がありません。Optimizerを使えば、新しいモデルに合わせてプロンプトの調整やfew-shot例の最適化を行いやすくなるからです。これにより、アプリケーションの保守性と移植性が劇的に向上します。

DSPyのアーキテクチャ:宣言的なフローで保守性を高める

DSPyのプログラムフローは非常に直感的です。講演で示された「メールからイベントを抽出し、カレンダーに登録する」という例で考えてみましょう。

まず、Signatureを使ってタスクを定義します。入力として「メールのスレッド本文」と「添付ファイル」、出力として「イベントのリスト」と「アクションアイテムのリスト」を指定します。

次に、このSignatureをdspy.ChainOfThoughtのようなModuleに渡します。これにより、「思考の連鎖」を用いてイベントを抽出する機能モジュールが完成します。

最後に、このプログラム全体をOptimizer(例えばMIPRO)に渡してコンパイルします。いくつかのメールのサンプルと、正しく抽出できたかを評価する簡単な関数を渡すだけで、Optimizerがプロンプトやサンプル例の調整を支援してくれます。

このように、個々のコンポーネントが明確な役割を持っているため、システム全体の見通しが良くなります。プロンプトという巨大な一枚岩を扱うのではなく、再利用可能なソフトウェア部品を組み合わせてシステムを構築する、まさにソフトウェア工学のアプローチです。

DSPy 3.0の進化:マルチモーダル、新オプティマイザー、そして強化学習

今回発表されたバージョン3.0では、DSPyはさらに強力なフレームワークへと進化を遂げました。

マルチモーダル対応の強化

Signatureの入力フィールドで、テキストだけでなく画像、PDF、音声ファイルなどを直接扱えるようになりました。これにより、メールに添付された画像をOCRツールで処理し、その内容を考慮してイベントを抽出する、といった複雑なパイプラインもエレガントに記述できます。

Simba Optimizerの登場

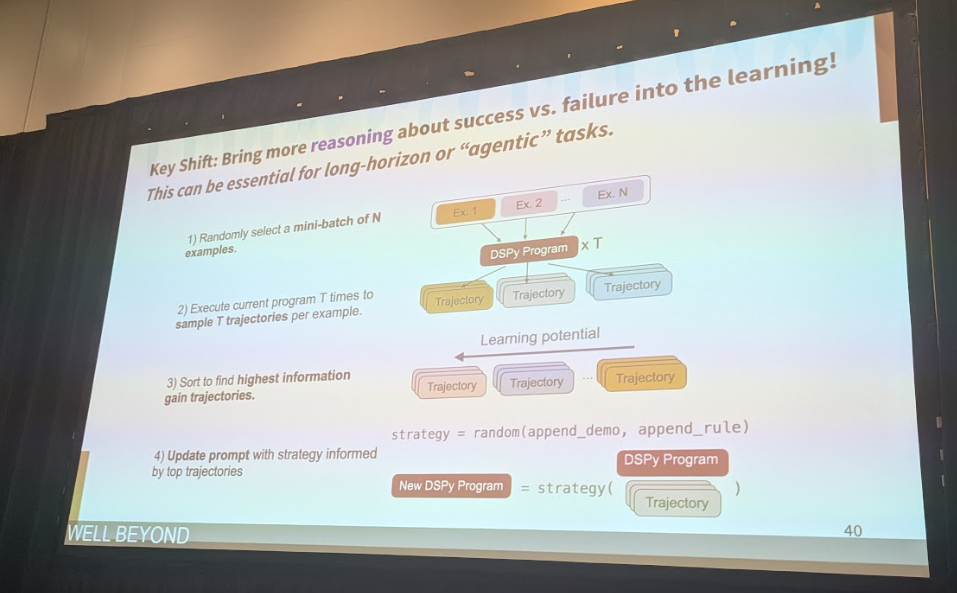

従来のMIPROに加え、Simbaという新しいプロンプトオプティマイザーが導入されました。Simbaの最大の特徴は、「推論(reasoning)」を活用して学習プロセス自体を最適化する点です。成功した実行例と失敗した実行例を比較し、「なぜ成功し、なぜ失敗したのか」をLLM自身に考えさせ、より効果的なプロンプトを生成します。Khattab氏によると、ある複数ステップの推論タスク(Two-hop task)では、Simbaを適用するだけで正解率が47%から70%へと飛躍的に向上したとのことです。

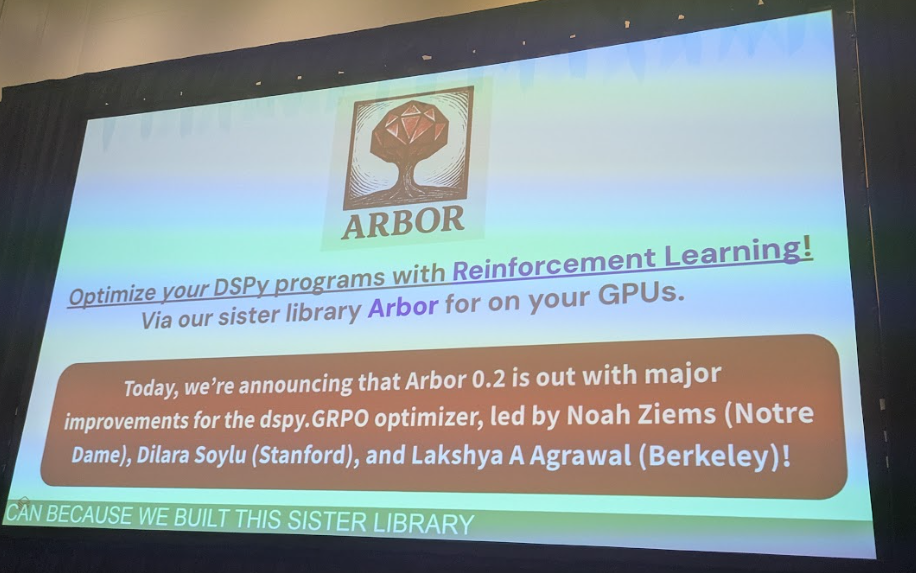

Arborによる強化学習(RL)

DSPy 3.0は、プロンプト最適化だけでなく、モデルの重み自体をファインチューニングする機能も大幅に強化しました。Arborという姉妹ライブラリと連携することで、DSPyで構築したプログラムに対して強化学習を適用できます。これにより、オープンソースモデルなどを特定のタスクに特化させ、さらなる性能向上を目指すことが可能になります。

この他にも、MLflowとのネイティブな統合による実験管理やデプロイの効率化など、プロダクション環境での利用を強く意識した機能改善が多数盛り込まれています。

導入事例と他フレームワークとの違い

DSPyはすでに多くの企業や研究機関で採用されています。Meta社はLlamaモデルへの移行を支援するツールにDSPyとMIPROを採用し、最大14%の性能向上を達成したと報告しています。また、AWSやコロンビア大学の研究、医療分野での画像診断レポート生成など、その活用事例は多岐にわたります。

LangChainのような他のフレームワークと比較した場合、DSPyの際立った特徴はその「抽象度の高さ」と「自動最適化」にあります。多くのフレームワークがLLMを呼び出すための便利なツールやオーケストレーション機能を提供する一方で、アプリケーションの核となるロジックは依然として開発者が手書きしたプロンプトに依存しています。

DSPyは、そのプロンプト自体をプログラムから分離し、データに基づいて自動で「コンパイル(最適化)」するという、より根本的なレベルで問題解決を図ります。これは、特定のLLMやプロンプトのテクニックに依存しない、真にポータブルで頑健なAIソフトウェアを構築するための設計思想と言えるでしょう。

まとめ:AIソフトウェアエンジニアリングの新たな標準へ

DSPy 3.0の登場は、LLMアプリケーション開発が「職人技」のフェーズを終え、体系化された「ソフトウェア工学」へと移行する大きな一歩を示しています。

プロンプトという不安定で扱いにくいものを抽象化し、Signatures, Modules, Optimizersという堅牢なコンポーネントに分解することで、私たちはついに、LLMを予測可能で保守性の高いソフトウェア部品として扱えるようになります。マルチモーダル対応や強化学習といった新機能は、その可能性をさらに広げるものです。

もちろん、すべての課題が解決されたわけではありません。しかし、DSPyが示す方向性は、これからのAIソフトウェア開発における一つの標準となっていく可能性を秘めています。今後のコミュニティの発展と、バージョン3.1、3.2で予定されているというアップデートにも大いに期待したいところです。