こんにちは、株式会社エーピーコミュニケーションズ、クラウド事業部の松尾です。

はじめに

本記事ではAWSのデータ移行サービスとストレージサービスについて比較してみたいと思います。

データ移行やストレージサービスの用途は様々ですが、主にユースケースの観点で見ていきます。

ゴール

本記事でお伝えすることは次の内容です。

- 主要なAWSのストレージサービスは何があるか

- 主要なAWSデータ移行方法は何があるか

- どのようなユースケースで使い分けるべきか

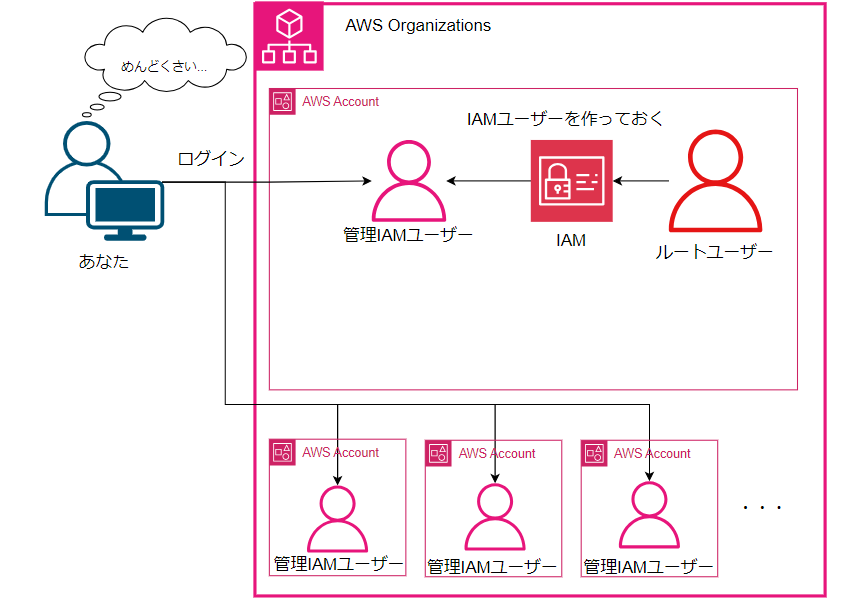

データ移行の全体イメージ

まず、データ移行の全体像のおさらいです。

大きく3つの要素に分けられます。

データがある「移行元」、データを移行する「移行方法」、データの「移行先」、の3つです。

データ移行元

移行元では、例えば次のような項目の検討が必要です。

移行方法や移行先の選定にも影響するので、現状の状況整理は重要。

- どこから?

→オンプレ?クラウド? - どんなデータを?

→システムイメージ?データベースレコード?ファイル単位? - どのくらいの容量?

→GB、TB、PB・・・?

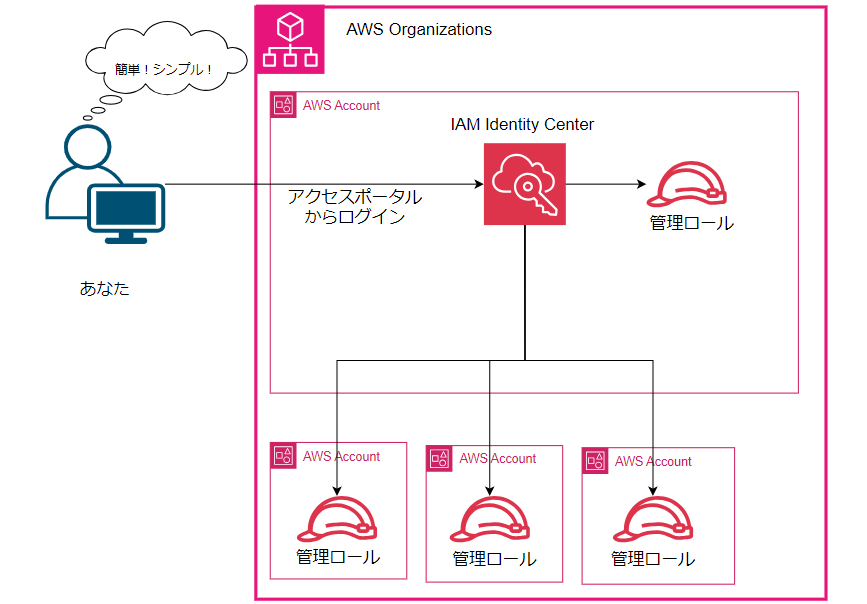

データ移行方法

移行方法としては、次のような項目検討が必要です。

- どんな方法で?

→オンライン?オフライン? - どんなデータを?(移行元での検討項目)

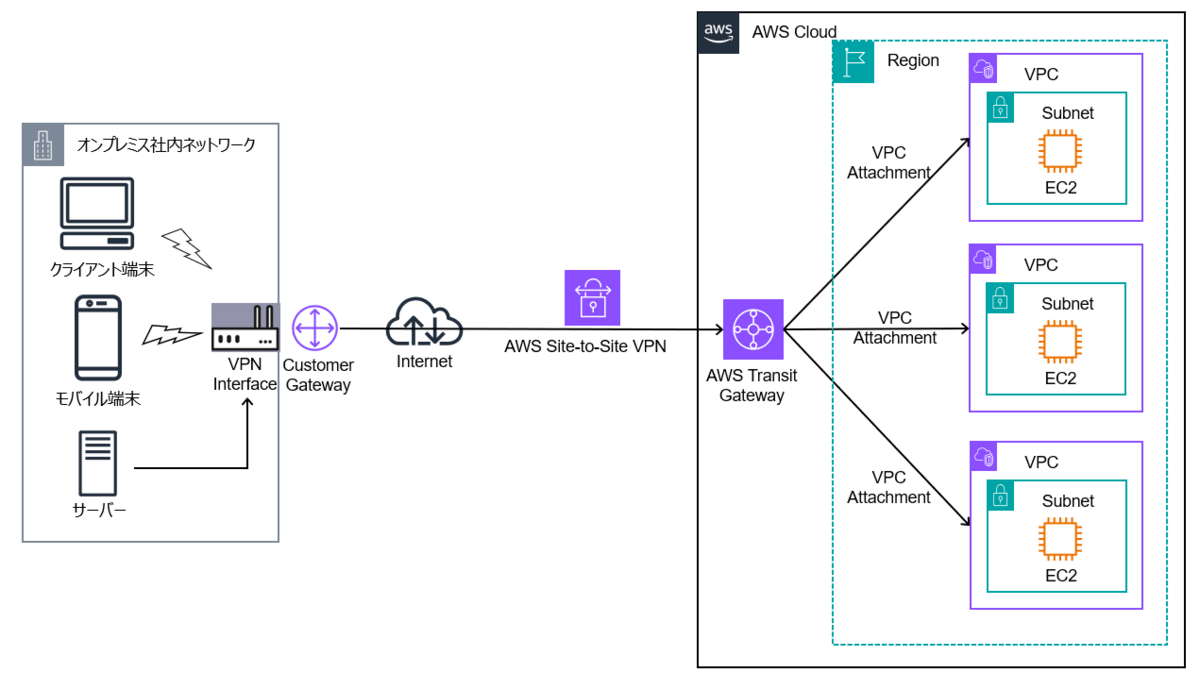

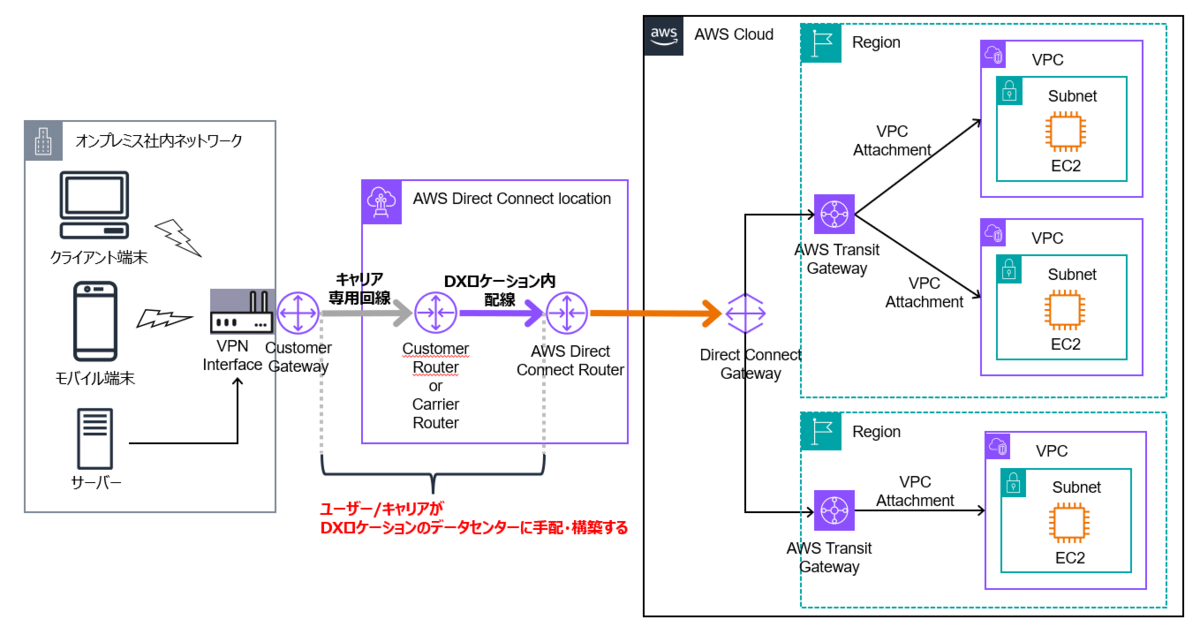

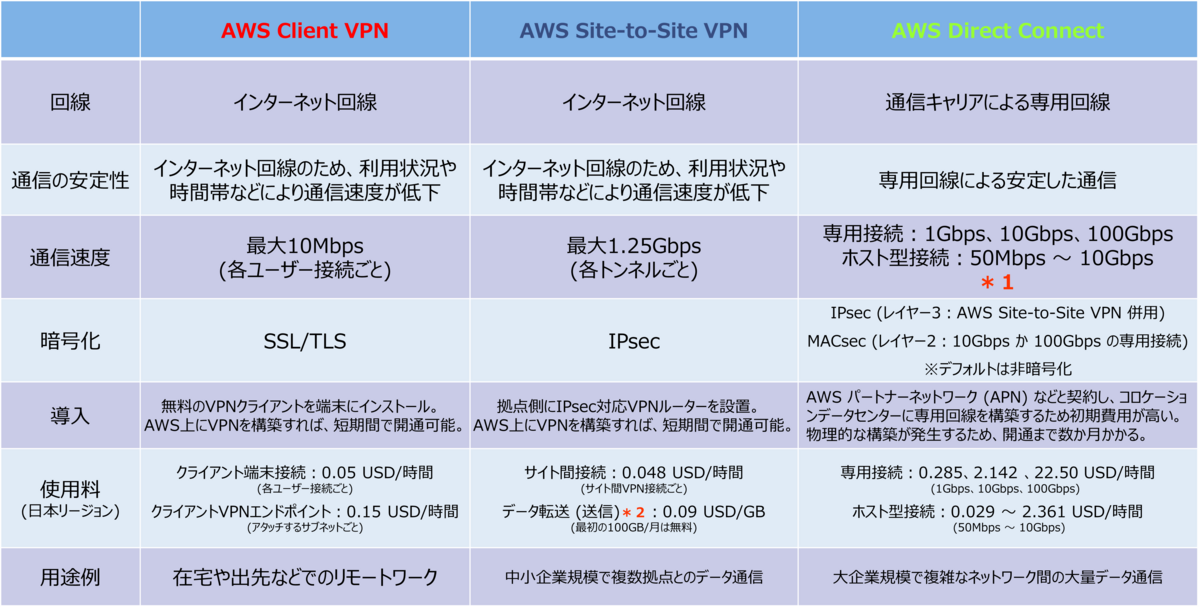

→システムイメージ?データベースレコード?ファイル単位? - 回線は何を使える?

→インターネット?VPN?専用線?クラウド内?

検討した項目でAWSサービスに当てはめてみます。

回線については専用線が最もセキュアですが、その分料金も高くなります。

移行するデータ量と、移行にかけられる時間、コスト、等のバランスで判断することになるかと思います。

| 方法 | データの種類 | AWSサービス | 特徴 | ユースケース |

|---|---|---|---|---|

| オンライン | システムイメージ | VM Import/Export | VMイメージの移行 | VM単位の移行 |

| オンライン | システムイメージ | AWS Server Migration Service | Hyper-V、VMware vSphereイメージの移行 | Hyper-V、VMware vSphereホストの移行 |

| オンライン | データベースレコード | AWS Database Migration Service | データベースのレプリケーション | データベースごと移行したい |

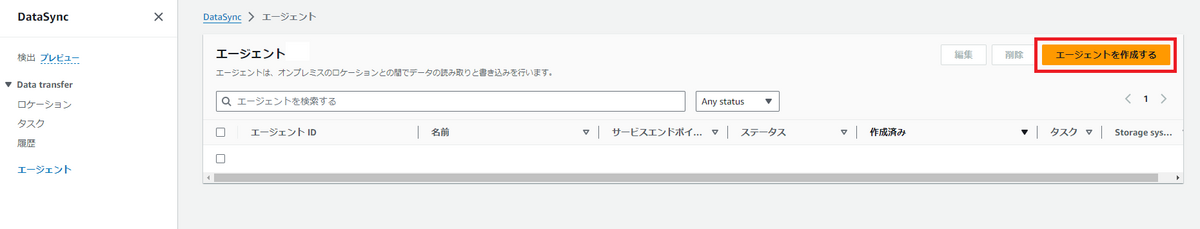

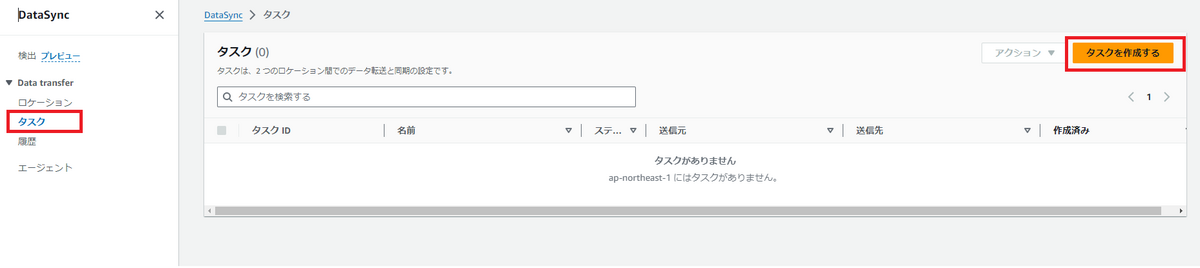

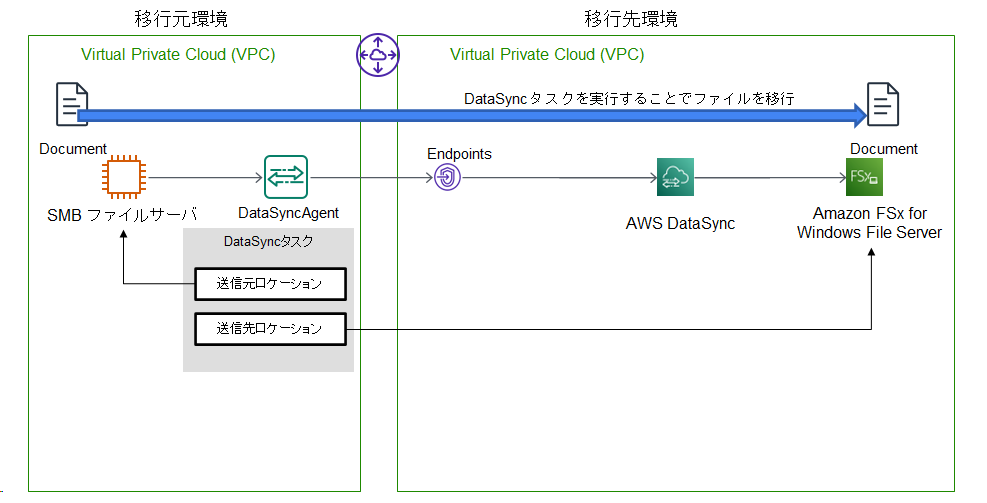

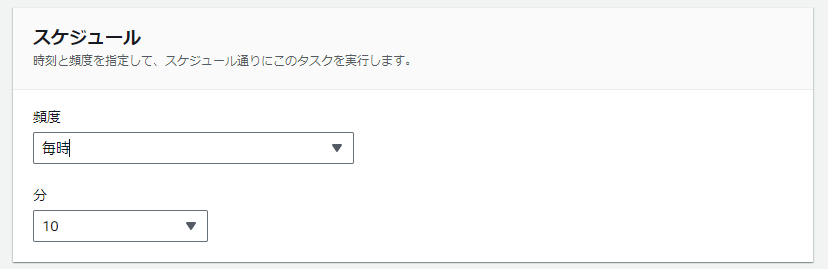

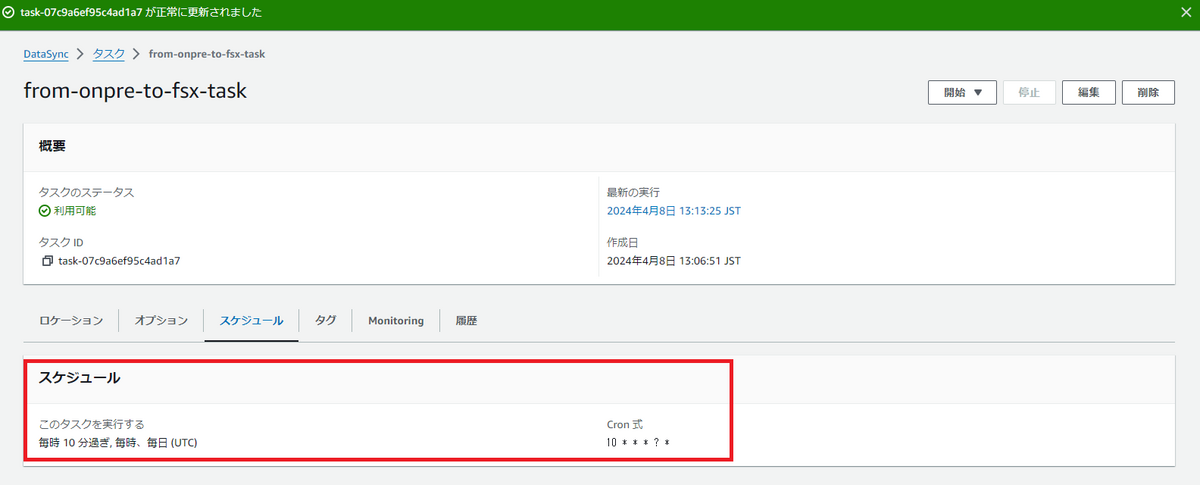

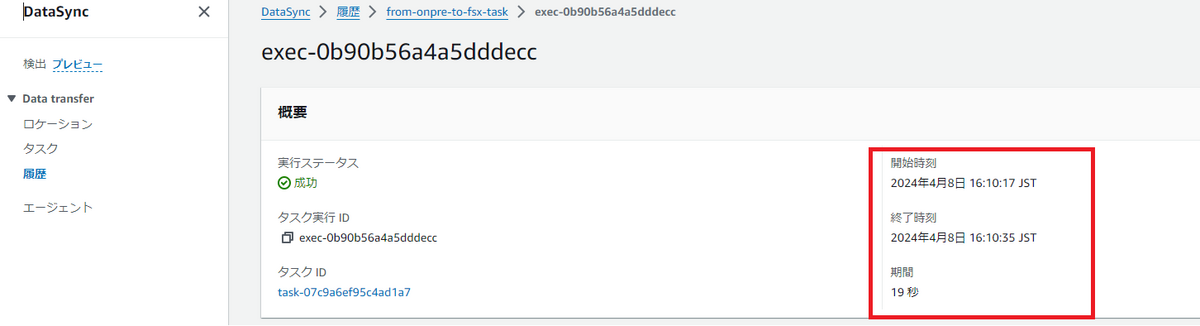

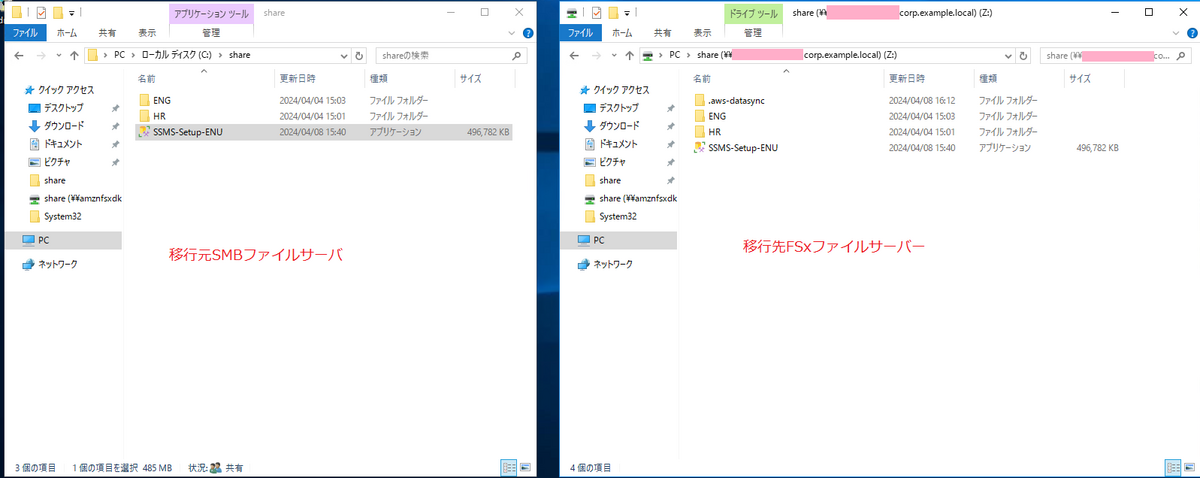

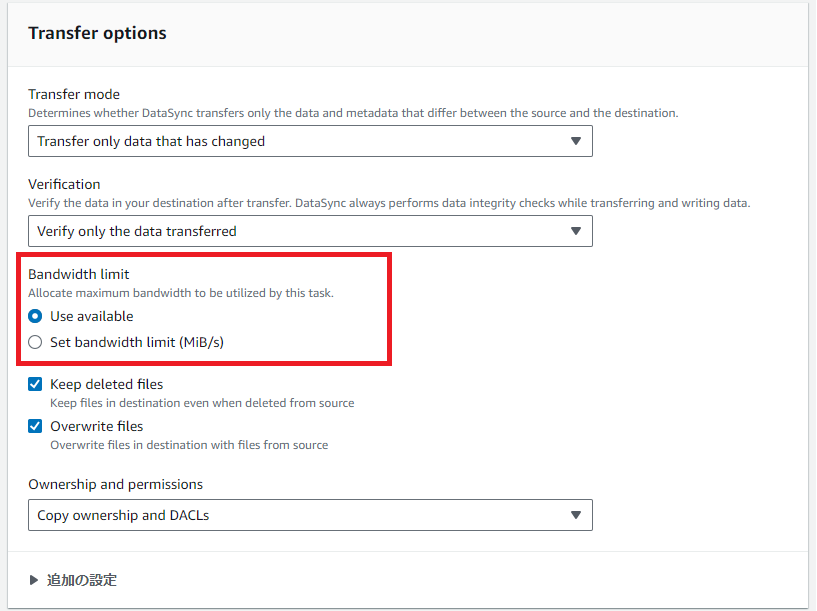

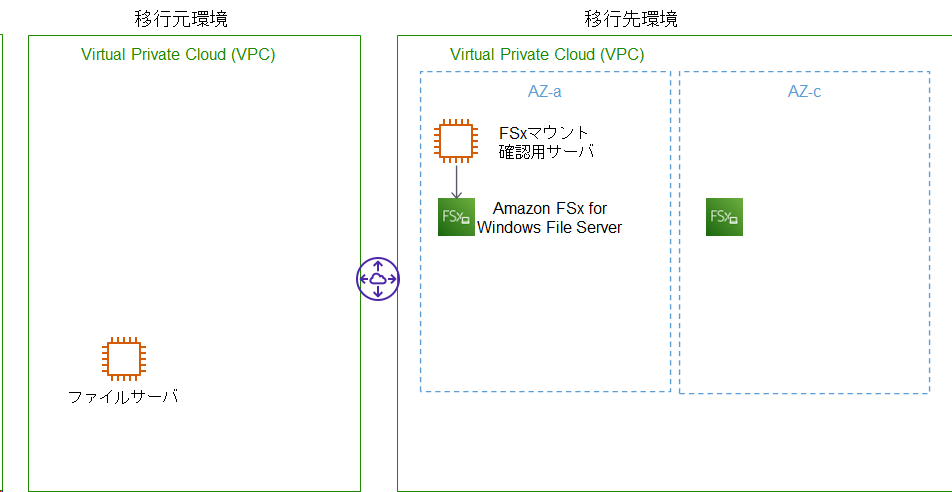

| オンライン | ファイル単位 | AWS DataSync | 暗号化、データ整合性検証、移行先AWSサービスを複数から選択可能、スケジュール機能 | ファイルサーバデータの移行、バックアップファイルの移行、差分同期もしたい |

| オンライン | ファイル単位 | AWS Storage Gateway | S3へのゲートウェイとして利用、SMB/NFS、iSCSI、VTLの各プロトコルに対応 | ファイルサーバデータの移行、バックアップファイルの移行、インターネット経由で移行したい、S3へ移行したい |

| オンライン | ファイル単位 | AWS Transfer Family | SFTP、FTPS、FTPプロトコルで転送 | 既存のプロトコルで移行したい |

| オフライン | ファイル単位 | AWS Snowcone | TBクラスのデータ移行、物理輸送 | 移行データ量がTBクラス、移行時間を最小化したい、オンライン移行で使える回線帯域が細い |

| オフライン | ファイル単位 | AWS Snowball | PBクラスのデータ移行、物理輸送 | 移行データ量がPBクラス、移行時間を最小化したい、オンライン移行で使える回線帯域が細い |

データ移行先

移行先としては、次のような項目検討が必要です。

移行元での検討項目と一部重複していますが。

- どこへ?

→オンプレ?クラウド? - どんな用途?

→データベース?ファイルサーバ?バックアップ?データレイク?

検討した項目でAWSサービスに当てはめてみます。

| 用途 | AWSサービス | 特徴 | ユースケース |

|---|---|---|---|

| データベース | Amazon EC2+Amazon EBS | スループット、I/Oの最適化可能 | 高速なI/Oが要求される、OSレイヤの設定が必要 |

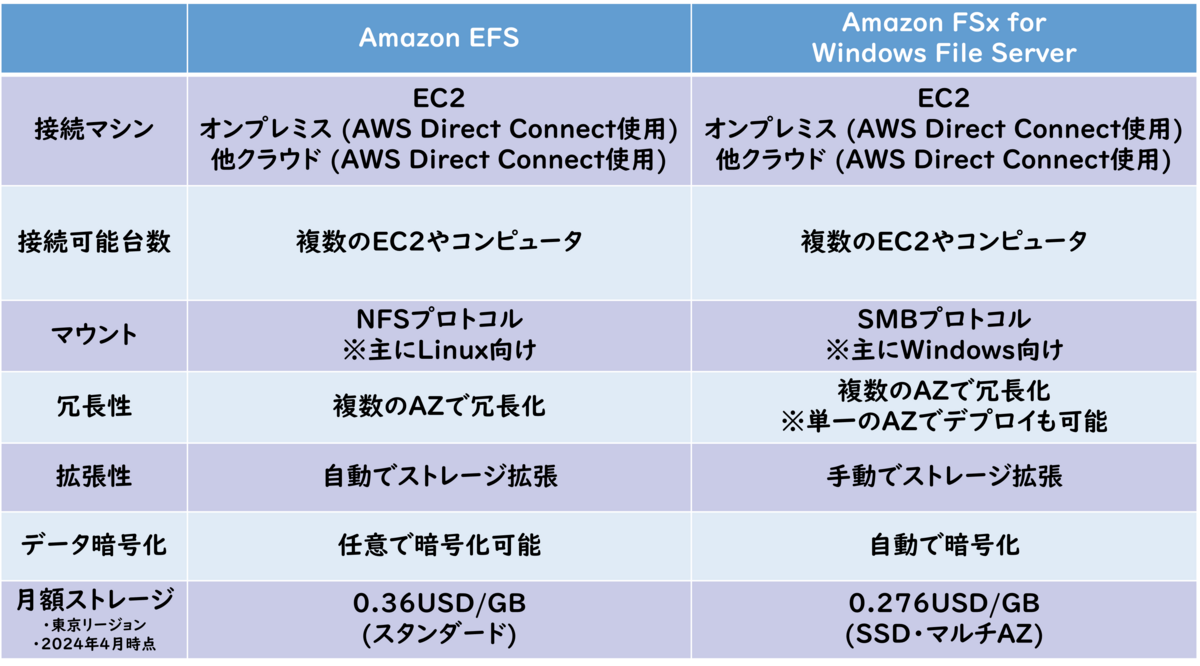

| ファイルサーバ | Amazon EFS | NFSプロトコルを使用、マネージドファイルサーバ | Linuxクライアント、NFSでアクセスしたい、マネージドのファイルサーバを使いたい |

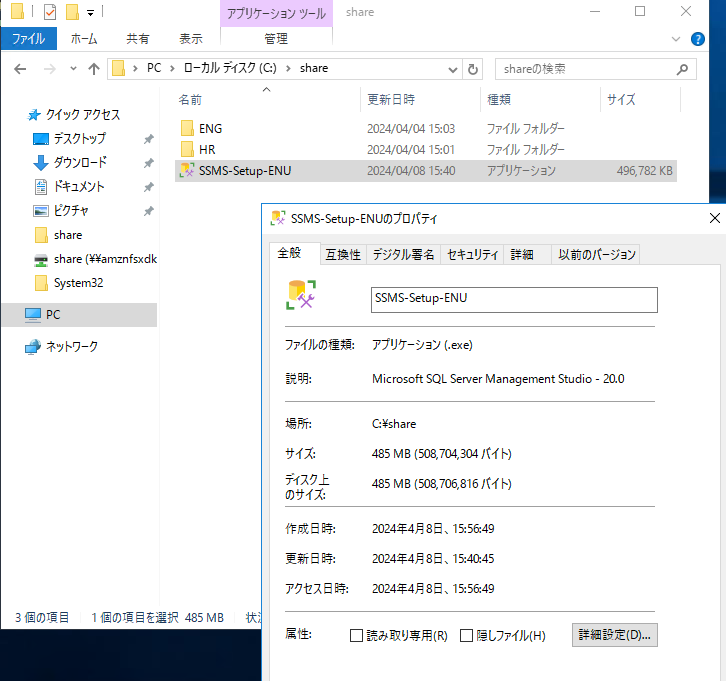

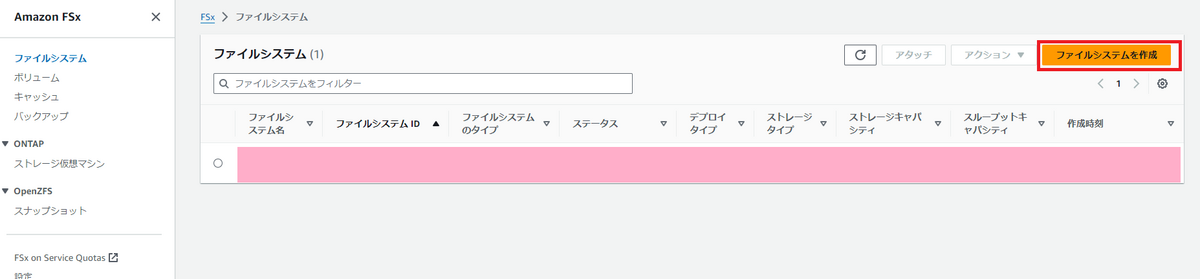

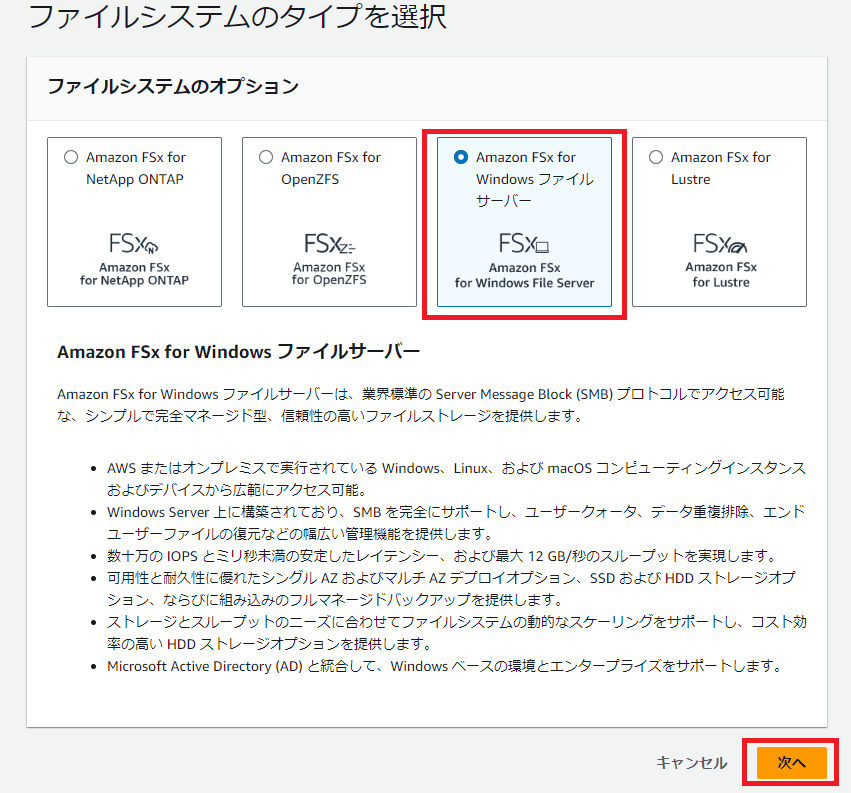

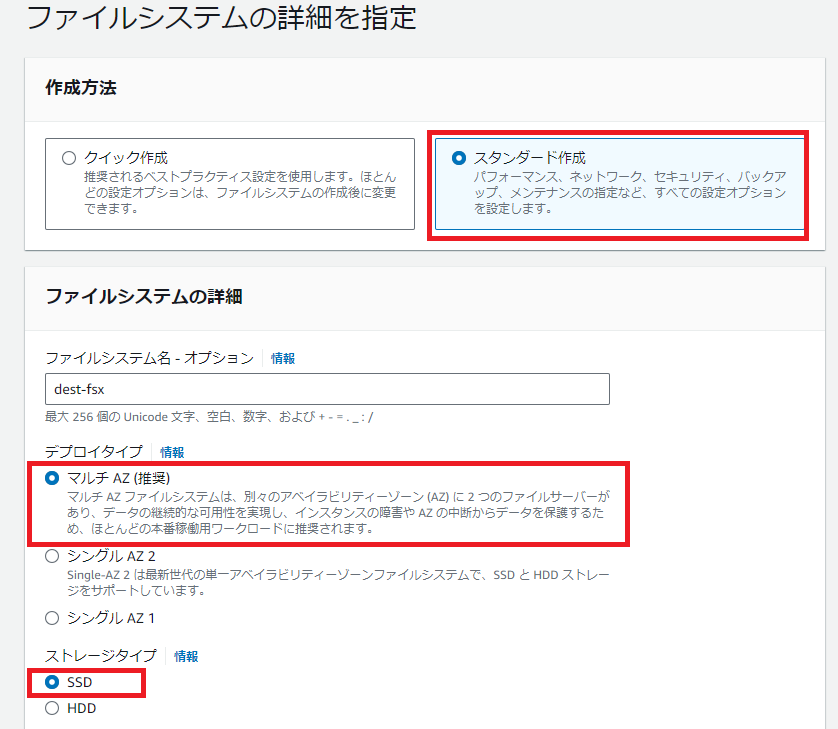

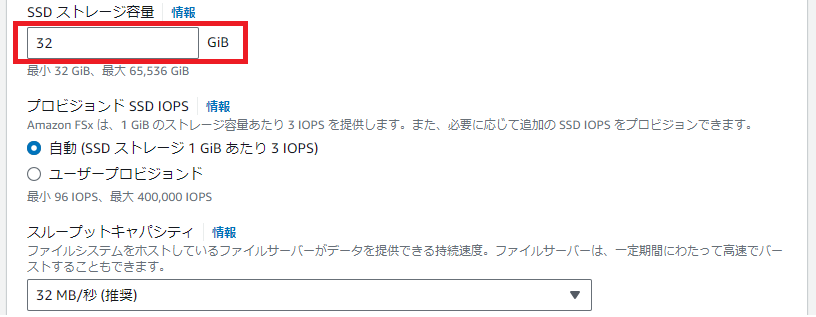

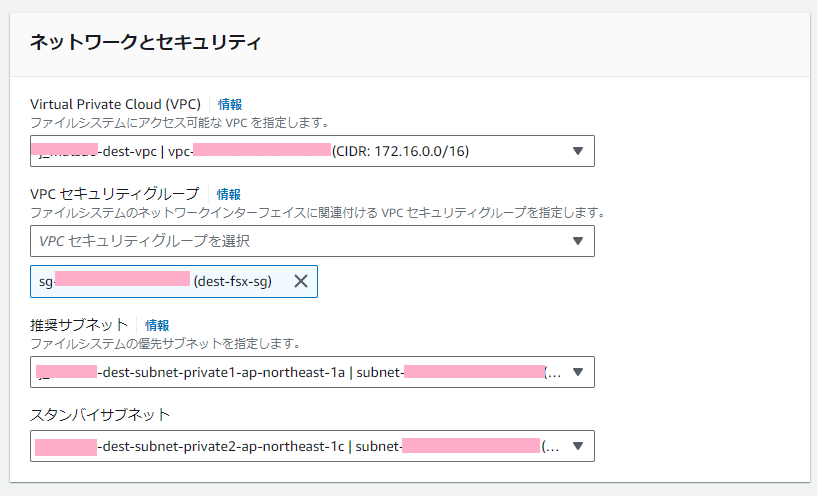

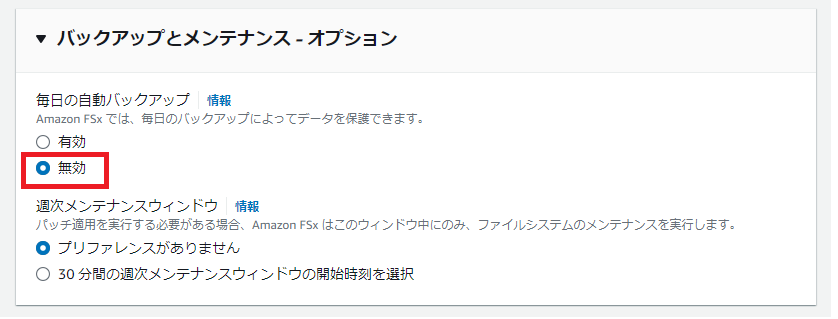

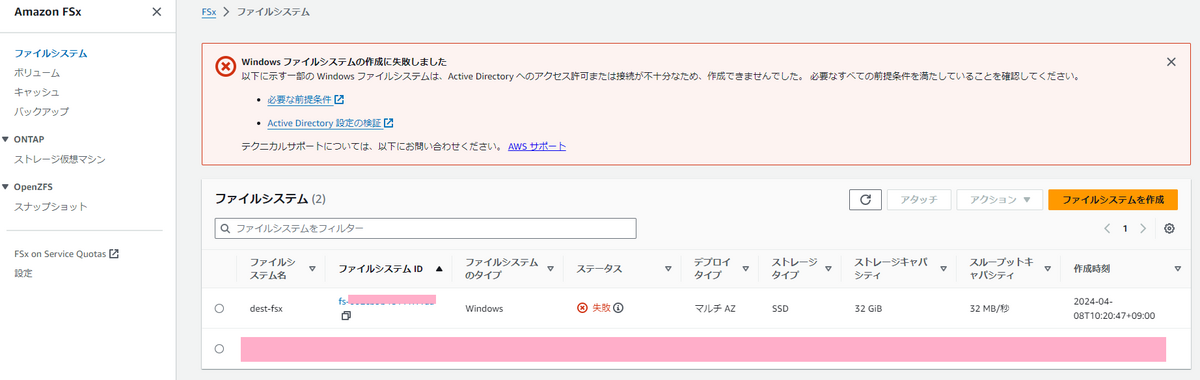

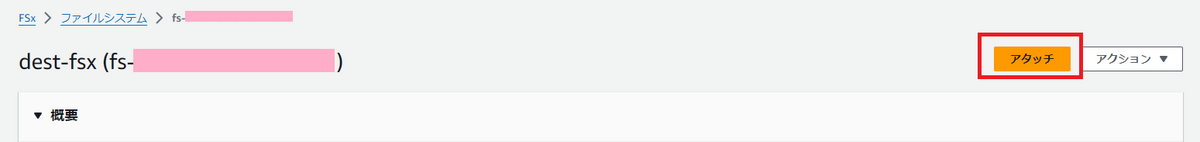

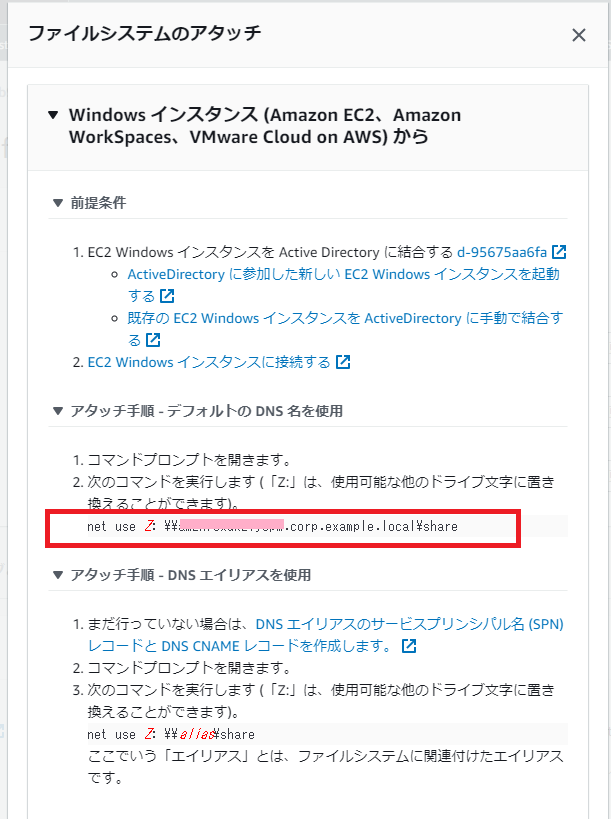

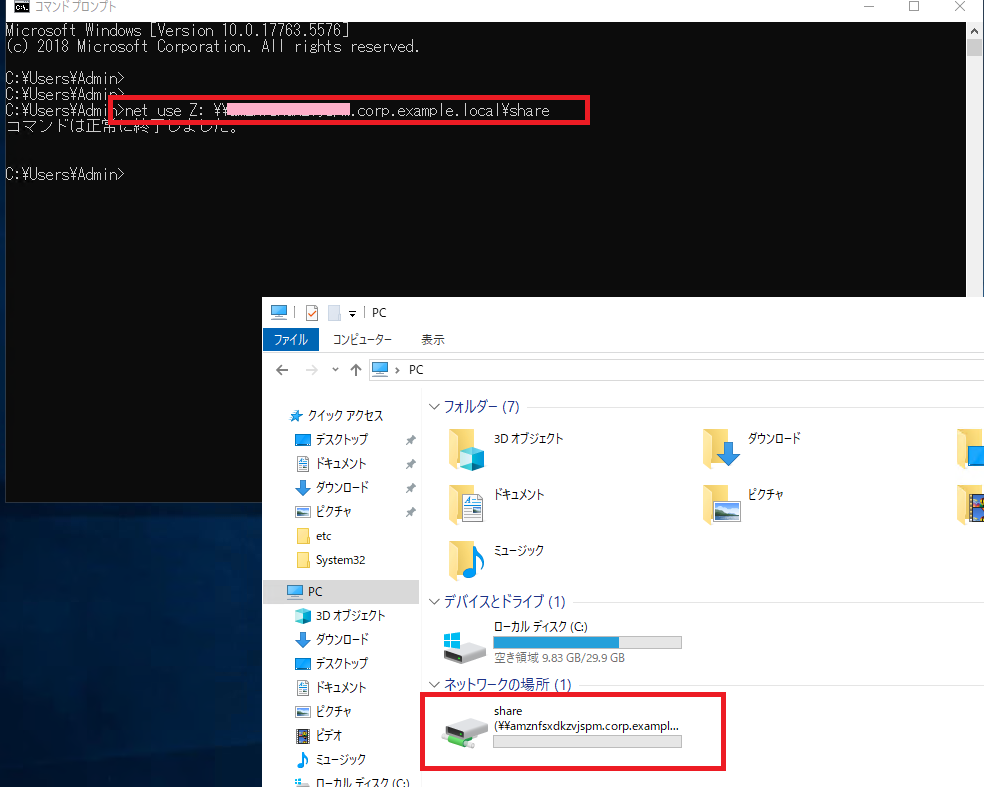

| ファイルサーバ | Amazon FSx for Windows File Server | SMBプロトコルを使用、マネージドファイルサーバ、IOPSやスループットを変更可能 | Windowsクライアントが多い、パラメータをチューニングしたい、SMBでアクセスしたい、ActiveDirecrotyで管理したい、マネージドのファイルサーバを使いたい |

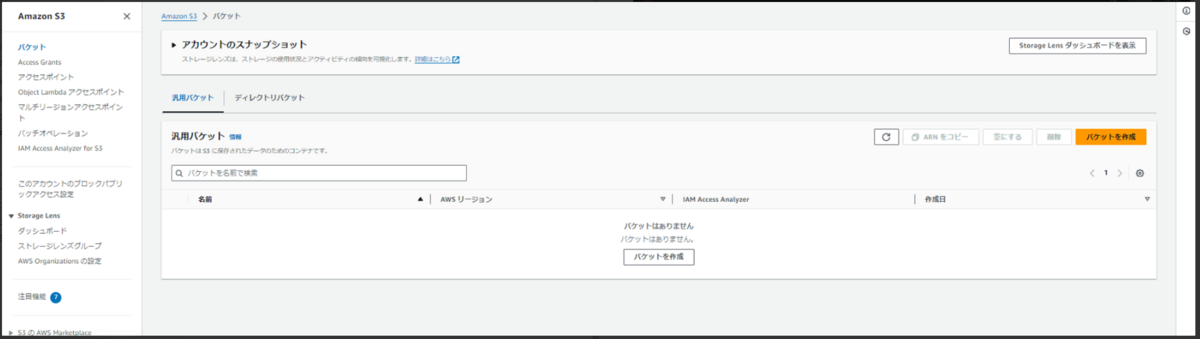

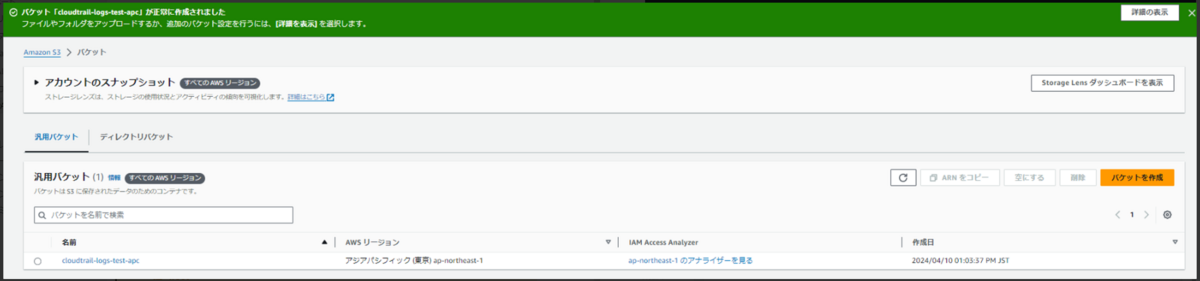

| バックアップ | Amazon S3 | 高耐久性、容量無制限、低コスト、HTTP/HTTPSアクセス | インターネット経由で安価にファイルを保存したい、アーカイブファイルが多い、使用頻度に応じてコストを削減したい |

| データレイク | Amazon S3 | 高耐久性、容量無制限、低コスト、HTTP/HTTPSアクセス | 安価にファイルを保存したい、他AWSサービスのストレージとして使いたい |

[番外編]

SaaSとの比較

ファイルサーバとSaaS型ファイル共有サービスを比較してみます。

どちらもOSレイヤの管理(WindowsUpdateやミドルウェアのパッチ管理など)は無く、容量も後から増強出来る点は共通しています。

ファイルサーバとしての性能を求めるなら、「ファイルサーバ」。

性能はそれほど求めず、外部ユーザのアクセスを想定するなら「SaaS型ファイル共有サービス」

といったユースケースでしょうか。

ファイルサーバ(Amazon FSx for Windows File Serverを想定)

メリット

- ファイル共有プロトコル(SMB)でアクセス可能

- 回線に依るが高速なファイルアクセス

- ActiveDirecrotyと連携

- OSレイヤの管理が不要

- 性能の増強が可能

- 容量の増加が可能

デメリット

- 容量を減らすことはできない

- AWS Site- to-Site VPNかDirectConnectが必要

SaaS型ファイル共有サービス(Amazon WorkDocsを想定)

メリット

- インターネット経由でアクセス可能

- OSレイヤの管理が不要

- ユーザ単位の管理/課金

- 外部ユーザのアクセス管理がしやすい

- ユーザ数とストレージの従量課金

デメリット

- ユーザ数が多いと高額になりがち

- インターネット経由のためスループットは安定しにくい(環境に依る)

ストレージの種別

最後にストレージの種別を整理しておきます。

ストレージは大きく次の3種類に分かれており、扱うプロトコルが違ってきます。

- ブロックストレージ

- ファイルストレージ

- オブジェクトストレージ

ざっくりですが特徴とユースケースは次のような分類。

| 種類 | 特徴 | ユースケース | AWSサービス |

|---|---|---|---|

| ブロックストレージ | SCSIプロトコルなど。ローカルドライブ。性能を最適化しやすい。 | 高速なアクセスが必要 | Amazon EBS |

| ファイルストレージ | SMB/NFSプロトコル。ファイルサーバと同様の仕組みでアクセス。 | 複数ユーザで共有したい | Amazon EFS、Amazon FSx for Windows File Server |

| オブジェクトストレージ | HTTP/HTTPSプロトコル。拡張性が高い。 | バックアップファイルやアーカイブファイル用途 | Amazon S3 |

参考資料

まとめ

ストレージと一口に言っても複数の種類があり、データ移行方法も多数あります。

「移行元」「移行方法」「移行先」ごとに条件を整理して、目的に合ったサービスを組み合わせていくことが重要です。

移行先ストレージ選定や移行方法検討のお役に立てれば幸いです。

おわりに

私達クラウド事業部はAWSなどのクラウド技術を活用したSI/SESのご支援をしております。

また、一緒に働いていただける仲間も募集中です! ご興味持っていただけましたらぜひお声がけください。